Korrelationsanalyse ist eine der zentralen Methoden, um Zusammenhänge in Daten sichtbar zu machen und Entscheidungen auf eine fundierte Basis zu stellen. Dieser Artikel erklärt Schritt für Schritt, wie Korrelationen berechnet, interpretiert und in der Praxis angewendet werden.

Der Artikel richtet sich an alle, die Daten nicht nur sammeln, sondern verstehen und nutzen möchten, um aus Beobachtungen klare Erkenntnisse abzuleiten. Zusätzlich enthält dieser Artikel einen kostenlosen, benutzerfreundlichen Korrelationsrechner.

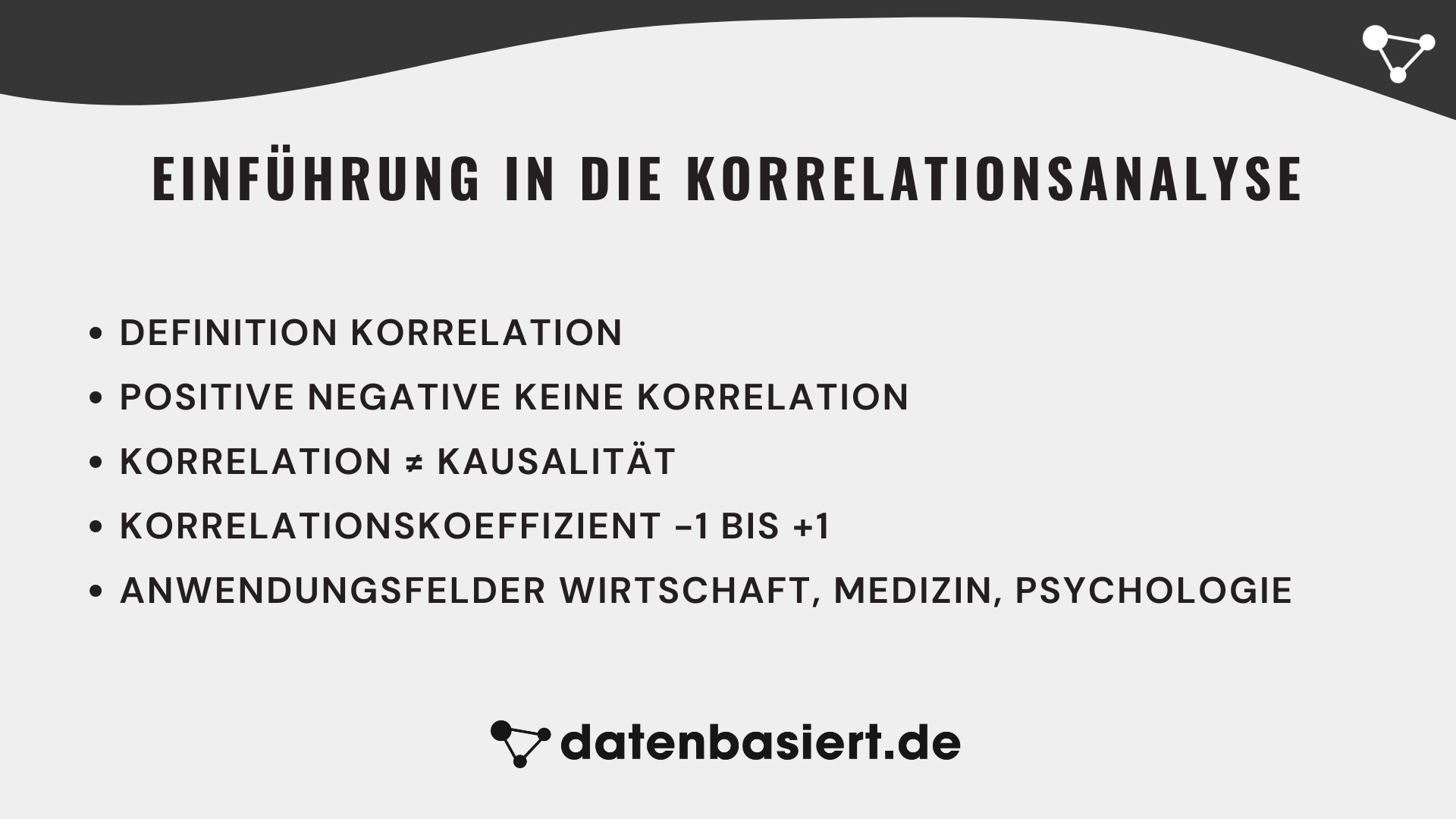

Einführung in die Korrelationsanalyse

Korrelationsanalyse ist ein grundlegendes Werkzeug der Statistik und Datenanalyse, mit dem untersucht wird, ob und wie stark zwei Variablen zusammenhängen. Sie zeigt, ob sich Werte gemeinsam verändern und in welcher Richtung dies geschieht. Diese Methode wird in nahezu allen Disziplinen eingesetzt, von Wirtschaft und Psychologie bis hin zu Medizin und Technik.

Im Kern beschreibt die Korrelationsanalyse die Stärke und Richtung einer Beziehung zwischen zwei Merkmalen. Sie beantwortet die Frage, ob hohe Werte der einen Variablen tendenziell mit hohen oder niedrigen Werten der anderen einhergehen. Dabei unterscheidet man zwischen positiver, negativer und keiner Korrelation.

- Positive Korrelation: Wenn eine Variable steigt, steigt auch die andere (zum Beispiel Einkommen und Konsumausgaben).

- Negative Korrelation: Wenn eine Variable steigt, sinkt die andere (zum Beispiel Geschwindigkeit und Fahrzeit auf einer festen Strecke).

- Keine Korrelation: Keine erkennbare Beziehung zwischen den Variablen.

Die Korrelationsanalyse ist kein Beweis für Ursache und Wirkung. Sie zeigt lediglich statistische Muster auf. Das bedeutet, auch wenn zwei Merkmale gemeinsam auftreten, muss das eine nicht das andere verursachen. Dieses Prinzip wird oft mit dem Satz zusammengefasst: Korrelation bedeutet nicht Kausalität.

Die Ergebnisse der Korrelationsanalyse werden meist als Korrelationskoeffizient ausgedrückt, einer Zahl zwischen −1 und +1. Je näher der Wert an ±1 liegt, desto stärker der Zusammenhang. Ein Wert von 0 zeigt keinen linearen Zusammenhang. Diese Kennzahl liefert eine klare quantitative Basis, um Beziehungen zwischen Variablen objektiv zu bewerten.

In der Praxis hilft die Korrelationsanalyse, Muster zu erkennen, Hypothesen zu prüfen und Modelle zu validieren. In der Wirtschaft kann sie etwa Zusammenhänge zwischen Preis und Nachfrage zeigen, in der Medizin Beziehungen zwischen Medikamentendosis und Wirkung, in der Psychologie Verbindungen zwischen Stressniveau und Leistung. Ihr universeller Einsatz macht sie zu einem der zentralen Instrumente der datenbasierten Entscheidungsfindung.

Korrelationsanalyse vs Regressionsanalyse: kurz erklärt

Korrelationsanalyse zeigt, ob und wie stark zwei Variablen zusammenhängen. Eine Regressionsanalyse geht darüber hinaus: Sie schätzt eine Gleichung, mit der sich ein Zielwert (Y) aus einem Einflussfaktor (X) berechnen lässt und macht damit den Zusammenhang als Effekt pro Einheit greifbar.

- Korrelation: Stärke und Richtung eines Zusammenhangs, ohne Ziel- und Einflussvariable festzulegen

- Regression: Y als Zielwert und X als Einflussfaktor, plus Gleichung für Schätzung und Vorhersage

Praktisch: Wenn du erst einmal nur wissen willst, ob zwei Größen gemeinsam schwanken, reicht oft die Korrelation. Wenn du wissen willst, wie sich Y typischerweise verändert, wenn X steigt oder fällt, ist die Regressionsanalyse das passendere Werkzeug.

Wenn du mehr zur Regressionsanalyse wissen willst, lies unseren Artikel zur Regressionsanalyse inklusive kostenlosem Online-Regressionsrechner.

Mathematische Grundlagen der Korrelationsanalyse

Die Korrelationsanalyse beruht auf klar definierten mathematischen Konzepten. Um ihre Ergebnisse richtig einzuordnen, ist es entscheidend, die Begriffe Kovarianz, Varianz und Standardabweichung zu verstehen. Diese Größen beschreiben, wie stark Datenpunkte um ihren Mittelwert streuen und wie sie gemeinsam variieren.

Die Varianz als Maß der Streuung

Bevor man über Zusammenhänge spricht, muss man verstehen, wie Werte innerhalb einer Variablen streuen. Die Varianz misst die durchschnittliche Abweichung der Daten vom Mittelwert. Eine hohe Varianz bedeutet, dass Werte stark auseinanderliegen. Eine geringe Varianz zeigt, dass sie sich eng um den Mittelwert gruppieren.

∑i=1n(xi − x)² |

| n − 1 |

Die Standardabweichung ist die Quadratwurzel der Varianz. Sie gibt an, wie weit die Werte durchschnittlich vom Mittelwert entfernt sind. Diese Größe ist leichter zu interpretieren, weil sie in derselben Einheit wie die Daten ausgedrückt wird.

Die Kovarianz als gemeinsames Streuungsmaß

Die Kovarianz beschreibt, wie stark zwei Variablen gemeinsam variieren. Wenn hohe Werte von X mit hohen Werten von Y auftreten, ist sie positiv. Wenn hohe Werte von X mit niedrigen Werten von Y einhergehen, ist sie negativ. Eine Kovarianz von null zeigt, dass kein linearer Zusammenhang besteht.

∑i=1n(xi − x)(yi − y) |

| n − 1 |

Die Kovarianz zeigt also, ob Variablen in die gleiche Richtung streuen, aber nicht, wie stark. Für eine aussagekräftige Interpretation muss sie daher standardisiert werden. Genau das geschieht im nächsten Schritt, bei der Berechnung des Korrelationskoeffizienten.

Warum Normierung notwendig ist

Da die Kovarianz von der Maßeinheit der Variablen abhängt, ist sie nicht direkt vergleichbar. Eine Kovarianz von 200 kann in einem Datensatz mit anderen Einheiten völlig andere Bedeutung haben als in einem anderen. Der Korrelationskoeffizient löst dieses Problem, indem er die Kovarianz durch das Produkt der Standardabweichungen beider Variablen teilt. Dadurch entsteht ein einheitsfreies Maß zwischen −1 und +1, das die Stärke und Richtung des Zusammenhangs eindeutig beschreibt.

Wer diese mathematischen Grundlagen versteht, kann die Ergebnisse der Korrelationsanalyse richtig einordnen und typische Fehlinterpretationen vermeiden. Damit sind die Voraussetzungen geschaffen, um im nächsten Kapitel die zentralen Kennzahlen der Korrelation zu verstehen und sicher anzuwenden.

Grundlagenbegriffe der Korrelationsanalyse

Die Korrelationsanalyse basiert auf einigen zentralen Begriffen, die ihre mathematische und inhaltliche Grundlage bilden. Wer sie versteht, kann nicht nur Zahlen berechnen, sondern ihre Bedeutung richtig einordnen. Die wichtigsten Begriffe sind Kovarianz, Korrelationskoeffizient und Signifikanz. Diese drei Größen zeigen, wie stark zwei Merkmale gemeinsam variieren, wie dieser Zusammenhang gemessen wird und ob er statistisch relevant ist.

Die Kovarianz als Ausgangspunkt

Die Kovarianz beschreibt, in welchem Maß zwei Variablen gemeinsam schwanken. Sie wird berechnet, indem man prüft, wie stark beide Werte jeweils vom Mittelwert abweichen und ob diese Abweichungen gemeinsam auftreten. Positive Kovarianz bedeutet, dass hohe Werte von X mit hohen Werten von Y verbunden sind. Negative Kovarianz zeigt, dass hohe Werte von X mit niedrigen Werten von Y einhergehen. Eine Kovarianz von null weist darauf hin, dass kein linearer Zusammenhang besteht.

∑i=1n(xi − x)(yi − y) |

| n − 1 |

Da die Kovarianz einheitenabhängig ist, lässt sich aus ihr nur bedingt erkennen, wie stark der Zusammenhang wirklich ist. Deshalb wird sie durch die Standardabweichungen der Variablen geteilt, um ein einheitsfreies Maß zu erhalten. Dieses Maß ist der Korrelationskoeffizient, der eine direkte und vergleichbare Aussage über Stärke und Richtung der Beziehung ermöglicht.

Vom Korrelationskoeffizienten zur Vergleichbarkeit

Der Korrelationskoeffizient wird berechnet, indem man die Kovarianz durch das Produkt der Standardabweichungen beider Variablen teilt. Das Ergebnis liegt immer zwischen −1 und +1. Je näher der Wert an +1 liegt, desto stärker ist der positive lineare Zusammenhang. Werte nahe −1 zeigen eine starke negative Beziehung. Ein Wert um 0 bedeutet, dass kein linearer Zusammenhang besteht.

Cov(X, Y) |

| σX · σY |

Signifikanz und Stichprobeneffekte

Ein Korrelationswert allein sagt nichts über seine statistische Zuverlässigkeit aus. Daher wird ein Signifikanztest durchgeführt, um zu prüfen, ob der beobachtete Zusammenhang zufällig entstanden sein könnte. Liegt der p-Wert unter 0,05, gilt der Zusammenhang in der Regel als statistisch signifikant. Doch große Stichproben können auch sehr kleine Zusammenhänge signifikant erscheinen lassen. Deshalb sollte zusätzlich das Konfidenzintervall angegeben werden, das den Bereich möglicher wahrer Werte beschreibt.

Wer Kovarianz, Korrelationskoeffizient und Signifikanz richtig versteht, kann Korrelationsanalysen präzise durchführen und ihre Ergebnisse sicher interpretieren. Diese Kenntnisse bilden das Fundament für alle weiterführenden statistischen Verfahren.

Methoden der Korrelationsanalyse

Es gibt verschiedene Methoden der Korrelationsanalyse, die je nach Art der Daten und Zielsetzung eingesetzt werden. Jede Methode hat eigene Voraussetzungen und Stärken. Die bekanntesten Verfahren sind die Pearson Korrelation, die Spearman Rangkorrelation, die Kendall Tau Korrelation und die partielle Korrelation.

Pearson Korrelation

Die Pearson Korrelation misst den linearen Zusammenhang zwischen zwei metrischen Variablen. Sie eignet sich für normalverteilte Daten und liefert präzise Ergebnisse, wenn der Zusammenhang tatsächlich linear ist. Der Korrelationskoeffizient r beschreibt sowohl Richtung als auch Stärke der Beziehung.

- Voraussetzungen: metrisches Skalenniveau, lineare Beziehung, keine starken Ausreißer

- Vorteile: weit verbreitet, leicht interpretierbar, mathematisch eindeutig

- Nachteile: anfällig für Ausreißer, ungeeignet bei nicht linearen Beziehungen

Spearman Rangkorrelation

Die Spearman Rangkorrelation, auch ρ (rho) genannt, eignet sich für ordinale oder nicht normalverteilte Daten. Sie untersucht den Zusammenhang der Rangordnung zweier Variablen. Das Verfahren ist robust gegenüber Ausreißern und kann auch bei monotonen, nicht linearen Beziehungen eingesetzt werden.

1 − 6∑di2 |

| n(n² − 1) |

Spearman ist die bevorzugte Methode, wenn Daten keine lineare Struktur aufweisen oder Extremwerte vorhanden sind. Sie ordnet Beobachtungen nach Rang und ist dadurch weniger empfindlich gegenüber Verzerrungen.

Kendall Tau Korrelation

Die Kendall Tau Korrelation basiert auf der Anzahl übereinstimmender und widersprechender Rangpaare. Sie ist ähnlich wie Spearman, aber mathematisch stabiler bei kleinen Stichproben. Das Verfahren eignet sich besonders gut, wenn die Daten viele gleiche Rangwerte enthalten.

- Vorteile: robust gegenüber Ausreißern, verlässlicher bei kleinen Stichproben

- Nachteile: rechenintensiver bei großen Datensätzen

Partielle Korrelation

Die partielle Korrelation misst den Zusammenhang zwischen zwei Variablen, während der Einfluss anderer Variablen konstant gehalten wird. Sie wird genutzt, um indirekte Beziehungen zu identifizieren und Scheinkorrelationen zu vermeiden. Ein Beispiel ist der Zusammenhang zwischen Einkommen und Lebenszufriedenheit, der durch die Variable Bildung beeinflusst werden kann.

Die Wahl der passenden Methode hängt von der Art der Daten und dem Forschungsziel ab. Pearson liefert präzise Ergebnisse bei metrischen und linearen Zusammenhängen. Spearman und Kendall sind besser geeignet, wenn Daten verzerrt oder nicht normalverteilt sind. Partielle Korrelationen sind notwendig, wenn komplexe Zusammenhänge untersucht werden sollen. Wer die Unterschiede versteht, kann die jeweils optimale Methode auswählen und belastbare Schlussfolgerungen ziehen.

Berechnung der Korrelationsanalyse

Die Korrelationsanalyse lässt sich mit einfachen mathematischen Schritten oder mit Hilfe von Statistiksoftware berechnen. Obwohl moderne Programme die Arbeit erleichtern, sollte man den Prozess verstehen, um die Ergebnisse korrekt zu bewerten und typische Fehler zu vermeiden. Die Berechnung folgt einem klaren Ablauf, der mit der Datenaufbereitung beginnt und mit der Interpretation der Ergebnisse endet.

Schritt 1: Datenaufbereitung

Bevor eine Korrelationsanalyse durchgeführt werden kann, müssen die Daten auf ihre Qualität geprüft werden. Fehlende Werte, Ausreißer oder falsche Einheiten können das Ergebnis stark verfälschen. Die Variablen müssen außerdem auf dem richtigen Skalenniveau gemessen sein. Pearson erfordert metrische Variablen, während Spearman und Kendall auch für ordinale Skalen geeignet sind.

- Überprüfe die Verteilung der Daten (zum Beispiel mit einem Shapiro-Wilk-Test).

- Identifiziere mögliche Ausreißer in einem Boxplot oder Streudiagramm.

- Prüfe, ob Variablen im richtigen Zahlenformat vorliegen.

Schritt 2: Berechnung der Korrelation

In der Praxis wird die Berechnung meist mit Programmen wie R, SPSS, Excel oder Python durchgeführt. Dennoch ist es wichtig, den mathematischen Kern zu kennen. Die Formel für die Pearson Korrelation lautet:

Cov(X, Y) |

| σX · σY |

Ein Beispiel verdeutlicht die Bedeutung:

Wenn man Lernzeit (X) und Prüfungsergebnis (Y) untersucht und eine Korrelation von r = 0,73 erhält, bedeutet dies einen starken positiven Zusammenhang. Personen mit längerer Lernzeit erzielen in der Regel bessere Ergebnisse.

Schritt 3: Signifikanztest

Nach der Berechnung wird überprüft, ob der gefundene Zusammenhang zufällig entstanden sein könnte. Der Signifikanztest prüft die Nullhypothese, dass keine lineare Beziehung besteht. Ein p-Wert kleiner als 0,05 bedeutet, dass die Nullhypothese verworfen werden kann und der Zusammenhang statistisch signifikant ist.

Schritt 4: Visualisierung der Ergebnisse

Eine grafische Darstellung erleichtert die Interpretation der Ergebnisse. Das einfachste Werkzeug ist der Scatterplot. Er zeigt, wie eng die Datenpunkte um eine gedachte Linie gruppiert sind. Je dichter die Punkte an einer Geraden liegen, desto stärker der lineare Zusammenhang.

- Positive Korrelation: Punkte verlaufen von links unten nach rechts oben.

- Negative Korrelation: Punkte verlaufen von links oben nach rechts unten.

- Keine Korrelation: Punkte bilden keine erkennbare Struktur.

Schritt 5: Interpretation

Die Interpretation sollte immer auf mehreren Ebenen erfolgen. Neben der reinen Zahl ist entscheidend, ob der Zusammenhang theoretisch plausibel ist und ob externe Faktoren eine Rolle spielen. Eine hohe Korrelation bedeutet nicht automatisch, dass eine Ursache-Wirkungs-Beziehung besteht. Deshalb sollte jede Analyse kritisch hinterfragt werden.

Wer die Berechnung versteht, kann Softwareergebnisse besser bewerten und erkennt, wann ein Wert statistisch relevant, aber inhaltlich bedeutungslos ist. Genau darin liegt der Unterschied zwischen Statistik und echter Analysekompetenz.

Korrelationsrechner

Mit diesem Online-Korrelationsrechner lässt sich der Zusammenhang zwischen zwei Variablen bestimmen: Er berechnet die Korrelationskoeffizienten nach Pearson, Spearman und Kendall sowie Kovarianz und den Determinationskoeffizienten (R²). Für Pearson wird außerdem der zweiseitige p-Wert (t-Test auf Nullkorrelation) ausgegeben. Ein Streudiagramm mit optionaler Trendlinie visualisiert die Daten; unvollständige Zeilen werden automatisch ignoriert.

Hinweis: Wie du die berechneten Werte (r, R², p-Wert, Spearman ρ und Kendall τ) inhaltlich einordnest, findest du ausführlich im nächsten Kapitel „Interpretation und Bedeutung der Korrelation“ – inklusive Faustregeln und Beispielen zur Stärke und Richtung des Zusammenhangs.

Interpretation und Bedeutung der Korrelation

Eine gefundene Korrelation ist erst dann wertvoll, wenn sie korrekt interpretiert wird. Zu oft werden Zahlen überbewertet oder falsch verstanden. Eine Korrelation beschreibt nur, wie stark zwei Merkmale gemeinsam variieren. Sie sagt nichts darüber aus, ob eines das andere verursacht. Der Unterschied zwischen Zusammenhang und Ursache ist entscheidend für die richtige Bewertung der Ergebnisse.

Korrelation ist nicht Kausalität

Ein häufiger Irrtum besteht darin, Korrelationen als Beweise für kausale Zusammenhänge zu deuten. Nur weil zwei Variablen gemeinsam verlaufen, bedeutet das nicht, dass eine die andere beeinflusst. Häufig gibt es Drittvariablen, die den beobachteten Zusammenhang erklären. So kann der Zusammenhang zwischen Eisverkäufen und Sonnenbränden durch die Variable Temperatur erklärt werden.

Solche Scheinkorrelationen sind weit verbreitet. Sie entstehen durch Zufall, unerkannte Zwischenvariablen oder methodische Verzerrungen. Ein klassisches Beispiel ist der scheinbare Zusammenhang zwischen Schokoladenkonsum und Nobelpreisen, der in Wirklichkeit durch das wirtschaftliche Entwicklungsniveau eines Landes beeinflusst wird.

Einfluss von Ausreißern und Datenqualität

Ausreißer können die Korrelationswerte erheblich verzerren. Ein einzelner Punkt, der weit vom Rest der Daten entfernt liegt, kann eine schwache Korrelation scheinbar stark erscheinen lassen oder umgekehrt. Daher sollten Ausreißer immer geprüft und, wenn begründet, entfernt oder gesondert analysiert werden.

Auch die Datenqualität spielt eine große Rolle. Ungenaue Messungen, fehlende Werte oder Rundungsfehler können Ergebnisse verfälschen. Eine sorgfältige Vorbereitung der Daten ist daher unverzichtbar, um belastbare Aussagen treffen zu können.

Richtung und Stärke richtig deuten

Die Richtung der Korrelation wird durch das Vorzeichen des Korrelationskoeffizienten angegeben. Ein positives Vorzeichen bedeutet, dass beide Variablen gemeinsam steigen oder fallen. Ein negatives Vorzeichen zeigt, dass sie sich entgegengesetzt entwickeln. Die Stärke wird durch den Betrag des Wertes beschrieben und reicht von 0 bis 1. Für die Einordnung helfen grobe Faustregeln (die je nach Fachgebiet abweichen können):

Pearson Korrelation (r)

Pearson r misst den linearen Zusammenhang zwischen zwei metrischen Variablen. Der Wert liegt zwischen −1 und +1: das Vorzeichen zeigt die Richtung, der Betrag die Stärke des linearen Zusammenhangs. Achtung: Bei nichtlinearen Mustern kann r trotz klarer Struktur klein sein.

- |r| < 0,10: praktisch kein linearer Zusammenhang (sehr schwach)

- 0,10 ≤ |r| < 0,30: schwacher linearer Zusammenhang

- 0,30 ≤ |r| < 0,50: moderater linearer Zusammenhang

- 0,50 ≤ |r| < 0,70: deutlicher linearer Zusammenhang

- 0,70 ≤ |r| < 0,90: starker linearer Zusammenhang

- |r| ≥ 0,90: sehr starker linearer Zusammenhang (nahezu perfekt)

- Vorzeichen: r > 0 = positiver Zusammenhang, r < 0 = negativer Zusammenhang

Spearman Rangkorrelation (ρ)

Spearman ρ (rho) bewertet den Zusammenhang über Rangplätze und misst damit einen monotonen Zusammenhang (steigend oder fallend), auch wenn dieser nicht linear ist. Dadurch ist Spearman oft robuster gegenüber Ausreißern und sinnvoll bei verzerrten oder ordinalen Daten.

- |ρ| < 0,10: praktisch kein monotoner Zusammenhang

- 0,10 ≤ |ρ| < 0,30: schwacher monotoner Zusammenhang

- 0,30 ≤ |ρ| < 0,50: moderater monotoner Zusammenhang

- 0,50 ≤ |ρ| < 0,70: deutlicher monotoner Zusammenhang

- 0,70 ≤ |ρ| < 0,90: starker monotoner Zusammenhang

- |ρ| ≥ 0,90: sehr starker monotoner Zusammenhang

- Vorzeichen: ρ > 0 = Ränge steigen gemeinsam, ρ < 0 = gegenläufige Rangentwicklung

Kendall Tau (τ)

Kendall τ betrachtet, wie häufig Rangpaare übereinstimmen (konkordant) oder widersprechen (diskordant). τ ist besonders stabil bei kleineren Stichproben und bei vielen gleichen Rangwerten (Ties). Typisch ist, dass τ betragsmäßig kleiner ausfällt als ρ oder r – das ist normal.

- |τ| < 0,10: praktisch kein Zusammenhang in den Rangpaaren

- 0,10 ≤ |τ| < 0,20: schwacher Zusammenhang

- 0,20 ≤ |τ| < 0,35: moderater Zusammenhang

- 0,35 ≤ |τ| < 0,50: deutlicher Zusammenhang

- |τ| ≥ 0,50: starker Zusammenhang (hohe Übereinstimmung der Rangpaare)

- Vorzeichen: τ > 0 = überwiegend übereinstimmende Paare, τ < 0 = überwiegend widersprechende Paare

Praktische Bedeutung

Die praktische Bedeutung einer Korrelation zeigt sich erst im Anwendungskontext. Eine Korrelation zwischen Bewegung und Wohlbefinden kann beispielsweise auf gesundheitsförderndes Verhalten hinweisen. In der Wirtschaft könnte ein positiver Zusammenhang zwischen Mitarbeiterzufriedenheit und Produktivität auf gute Arbeitsbedingungen deuten. Entscheidend ist, die Zahlen mit Inhalt zu füllen und sie im Kontext zu verstehen.

Eine Korrelationsanalyse ist kein Selbstzweck. Sie ist ein Werkzeug, das hilft, Muster zu erkennen und Hypothesen zu entwickeln. Ihre Aussagekraft hängt von der Qualität der Daten, der gewählten Methode und der Fähigkeit zur kritischen Interpretation ab. Wer diese Balance beherrscht, kann Korrelationen sinnvoll in Erkenntnisse umwandeln.

Typische Fehler und Missverständnisse

Auch erfahrene Analysten interpretieren Korrelationen manchmal falsch. Fehler entstehen häufig durch unkritische Anwendung, ungeeignete Datengrundlagen oder falsche Schlussfolgerungen. Das Verständnis typischer Fallstricke ist entscheidend, um zuverlässige Ergebnisse zu erzielen und Fehlinterpretationen zu vermeiden.

Scheinkorrelationen

Scheinkorrelationen sind Zusammenhänge, die nur scheinbar bestehen. Sie entstehen, wenn eine Drittvariable beide betrachteten Variablen beeinflusst. So kann etwa ein positiver Zusammenhang zwischen der Anzahl von Feuerwehrleuten und der Höhe des Brandschadens beobachtet werden. In Wirklichkeit erklärt sich dieser Zusammenhang dadurch, dass größere Brände mehr Feuerwehrleute erfordern.

Einfluss von Ausreißern

Ausreißer können den Korrelationswert erheblich verfälschen. Ein einzelner extrem hoher oder niedriger Wert kann die Beziehung zwischen zwei Variablen über- oder unterschätzen. Daher sollten Ausreißer immer geprüft werden, bevor eine Analyse durchgeführt wird. Wenn sie sachlich erklärbar sind, dürfen sie beibehalten werden. Andernfalls sollten sie aus der Berechnung ausgeschlossen werden.

Verwechslung von linearen und nicht linearen Beziehungen

Die Pearson Korrelation misst nur lineare Zusammenhänge. Wenn die Beziehung zwischen zwei Variablen nicht linear ist, kann der Korrelationswert täuschend niedrig erscheinen, obwohl ein klarer Zusammenhang besteht. In solchen Fällen sollte man alternative Verfahren wie die Spearman Rangkorrelation oder die Berechnung von Regressionsmodellen in Betracht ziehen.

Überinterpretation von Signifikanz

Eine statistisch signifikante Korrelation bedeutet nicht automatisch, dass der Zusammenhang praktisch bedeutsam ist. Große Stichproben können kleine Effekte signifikant erscheinen lassen. Umgekehrt können starke Zusammenhänge in kleinen Stichproben statistisch nicht signifikant wirken. Deshalb sollten p-Wert, Effektstärke und Kontext immer gemeinsam betrachtet werden.

Vernachlässigung der Datenqualität

Fehlerhafte oder unvollständige Daten führen zwangsläufig zu unzuverlässigen Ergebnissen. Fehlende Werte, ungleiche Skalen oder Messfehler können eine Analyse entwerten. Eine sorgfältige Datenprüfung ist daher eine Grundvoraussetzung für jede seriöse Auswertung. Nur qualitativ hochwertige Datensätze liefern verlässliche Korrelationen.

Die Kenntnis dieser Fehlerquellen ist entscheidend, um statistische Ergebnisse nicht nur korrekt zu berechnen, sondern auch verantwortungsvoll zu interpretieren. Eine saubere Methode schützt vor falschen Schlussfolgerungen und stärkt die wissenschaftliche Aussagekraft jeder Analyse.

Beispiele und Anwendung der Korrelationsanalyse

Die Korrelationsanalyse ist ein unverzichtbares Werkzeug für datengetriebene Entscheidungen in Unternehmen. Sie zeigt, wie eng verschiedene Geschäftskennzahlen miteinander verbunden sind und ermöglicht es, Muster und Abhängigkeiten zu erkennen, die sonst verborgen bleiben würden. Besonders in Marketing, Vertrieb, Projektmanagement und Kundenservice spielt sie eine wichtige Rolle, um strategische Entscheidungen zu optimieren und operative Prozesse zu verbessern.

Korrelationsanalyse im Marketing

Im Marketing hilft die Korrelationsanalyse, den Zusammenhang zwischen Kampagnenaktivitäten und Geschäftsergebnissen zu verstehen. Unternehmen analysieren, welche Marketingkanäle am stärksten mit Umsatz oder Markenbekanntheit korrelieren. So lassen sich Investitionen gezielter steuern und Kampagnen effizienter gestalten.

- Beispiel: Eine positive Korrelation zwischen organischem Website-Traffic und Conversion-Rate zeigt, dass Content-Marketing-Maßnahmen nicht nur Reichweite, sondern auch Abschlüsse fördern.

- Beispiel: Eine Analyse könnte ergeben, dass Social-Media-Aktivität stark mit der Markenwahrnehmung, aber weniger mit direktem Umsatz korreliert – ein Hinweis auf den Branding-Charakter solcher Kanäle.

Korrelationsanalyse im Vertrieb

Im Vertrieb unterstützt die Korrelationsanalyse das Verständnis von Erfolgsfaktoren im Verkaufsprozess. Sie kann zeigen, welche Variablen den Abschlusswahrscheinlichkeiten am stärksten zugeordnet sind – etwa Kundengröße, Kontaktfrequenz oder Angebotszeitpunkt. So lassen sich Prognosen verbessern und Vertriebsstrategien datenbasiert optimieren.

- Beispiel: Eine starke positive Korrelation zwischen Kontaktfrequenz und Abschlussquote weist darauf hin, dass kontinuierliche Betreuung die Verkaufschancen erhöht.

- Beispiel: Eine negative Korrelation zwischen Angebotspreis und Abschlussquote kann helfen, Preisstrategien realistischer zu gestalten.

Korrelationsanalyse im Projektmanagement

Im Projektmanagement kann die Korrelationsanalyse helfen, Erfolgsfaktoren systematisch zu erkennen. Projektteams können prüfen, welche Kennzahlen – etwa Kommunikationshäufigkeit, Ressourcenauslastung oder Planungsgenauigkeit – mit Projekterfolg, Termintreue oder Budgettreue korrelieren. Das ermöglicht datenbasierte Verbesserungen im Projektablauf.

- Beispiel: Eine hohe Korrelation zwischen klar definierten Projektzielen und Erfolgsquote weist darauf hin, dass präzise Zieldefinition ein zentraler Erfolgsfaktor ist.

- Beispiel: Eine negative Korrelation zwischen Teamgröße und Entscheidungsdauer kann auf Effizienzverluste durch zu komplexe Abstimmungen hinweisen.

Korrelationsanalyse im Kundenservice und CRM

Im Kundenservice und Customer-Relationship-Management hilft die Korrelationsanalyse, den Einfluss von Servicequalität, Reaktionszeit und Kundenzufriedenheit auf Loyalität oder Umsatz zu verstehen. Unternehmen können so erkennen, welche Servicefaktoren den größten Beitrag zur Kundenbindung leisten.

- Beispiel: Eine hohe Korrelation zwischen Erstlösungsquote und Kundenzufriedenheit zeigt, dass schnelle Problemlösung die wichtigste Stellschraube für Loyalität ist.

- Beispiel: Eine Analyse kann ergeben, dass die Korrelation zwischen Zufriedenheit und Wiederkaufabsicht stärker ist als die zwischen Zufriedenheit und Weiterempfehlungsrate – ein Hinweis auf Kaufverhalten als primären Wirkungsbereich.

In allen Bereichen gilt: Die Korrelationsanalyse macht Zusammenhänge messbar und liefert eine Grundlage für datenbasiertes Management. Sie ersetzt keine Kausalitätsanalyse, zeigt aber präzise, welche Beziehungen es wert sind, weiter untersucht zu werden. So wird sie zu einem Schlüsselwerkzeug in der modernen Unternehmensanalyse.

Software und Tools für die Korrelationsanalyse

Die Korrelationsanalyse lässt sich mit einer Vielzahl von Softwarelösungen und Analysetools durchführen. Von Tabellenkalkulationsprogrammen über professionelle Statistiksoftware bis hin zu modernen Data Science Frameworks steht heute eine breite Palette an Werkzeugen zur Verfügung. Die Wahl des richtigen Tools hängt vom Anwendungszweck, der Datenmenge, den technischen Fähigkeiten der Anwender und den Anforderungen an Visualisierung und Automatisierung ab.

Tipp: Auf dieser Seite stellen wir Ihnen außerdem ein kostenloses und leicht zu bedienendes Online-Korrelationsanalyse-Tool zur Verfügung – klicken Sie dazu HIER, um es jetzt zu nutzen.

Excel und Google Sheets

Für einfache Analysen sind Excel und Google Sheets weit verbreitet. Sie bieten integrierte Funktionen zur Berechnung der Pearson und Spearman Korrelation sowie Möglichkeiten zur Erstellung von Streudiagrammen. Besonders in kleinen Unternehmen oder bei schnellen Analysen sind diese Werkzeuge ausreichend.

- Vorteile: Einfach in der Anwendung, keine Programmierkenntnisse erforderlich, schnelle Visualisierung.

- Nachteile: Begrenzte Rechenleistung bei großen Datenmengen, keine erweiterten Verfahren für partielle oder nichtlineare Korrelationen.

SPSS und SAS

SPSS und SAS sind professionelle Statistikprogramme, die seit Jahrzehnten in Forschung und Wirtschaft eingesetzt werden. Sie ermöglichen die Berechnung unterschiedlichster Korrelationsmaße, Signifikanztests und partieller Korrelationen. Besonders in der Marktforschung, Psychologie und im Controlling gelten sie als Standardwerkzeuge.

- Vorteile: Umfangreiche Statistikbibliothek, hohe Stabilität, benutzerfreundliche Oberfläche.

- Nachteile: Lizenzkosten, eingeschränkte Flexibilität bei individuellen Analysen.

R und Python

R und Python sind aktuell die beliebtesten Tools zur Korrelationsanalyse weltweit. Beide Sprachen bieten leistungsstarke Bibliotheken für Statistik, maschinelles Lernen und Datenvisualisierung. Sie erlauben eine tiefgehende Automatisierung und Integration in komplexe Analyseprozesse.

- R: Ideal für statistische Analysen mit Paketen wie corrplot, Hmisc oder psych. Besonders geeignet für Forschung und Data Science.

- Python: Bibliotheken wie Pandas, NumPy und Seaborn ermöglichen die Berechnung und Visualisierung von Korrelationsmatrizen in großen Datensätzen.

Business Intelligence Plattformen

BI Tools wie Tableau, Power BI oder Qlik ermöglichen es, Korrelationen visuell zu analysieren, ohne programmieren zu müssen. Sie sind ideal, um Muster in Echtzeit zu erkennen und Management Dashboards zu erstellen, die Korrelationen automatisch visualisieren. In Kombination mit Unternehmensdatenbanken können sie Zusammenhänge in Marketing, Vertrieb oder CRM Daten transparent machen.

- Vorteile: Interaktive Visualisierung, Anbindung an Datenbanken, geeignet für Führungskräfte und Analysten.

- Nachteile: Eingeschränkte Flexibilität bei komplexen statistischen Tests, Fokus auf Darstellung statt Tiefe.

Tools für Big Data und maschinelles Lernen

In datenintensiven Umgebungen kommen spezialisierte Tools wie Apache Spark, Databricks oder KNIME zum Einsatz. Sie verarbeiten Millionen von Datensätzen parallel und bieten integrierte Funktionen zur Korrelationsanalyse und Feature Selektion. Dadurch lassen sich selbst in sehr großen Datensätzen Muster und Abhängigkeiten erkennen, die in klassischen Anwendungen verborgen bleiben.

- Beispiel: In einem CRM System mit Millionen von Kundendaten kann Spark Korrelationen zwischen Kundeninteraktionen, Kaufverhalten und Kündigungswahrscheinlichkeit berechnen.

Wahl des richtigen Werkzeugs

Die Auswahl des passenden Tools sollte sich an Ziel, Datenumfang und Benutzerkompetenz orientieren. Kleine Teams profitieren von Excel oder BI Tools, während datenintensive Organisationen mit Python, R oder Spark mehr Flexibilität und Tiefe erreichen. Entscheidend ist, dass das Tool nicht nur die Berechnung, sondern auch die Interpretation unterstützt. Die beste Software nützt wenig, wenn ihre Ergebnisse nicht richtig verstanden oder kommuniziert werden.

Eine effiziente Nutzung der Korrelationsanalyse hängt daher weniger von der Technologie ab als vom analytischen Denken der Anwender. Die Verbindung von statistischem Wissen, technischer Kompetenz und inhaltlichem Verständnis bleibt der entscheidende Erfolgsfaktor, unabhängig vom gewählten Tool.

Fazit und Ausblick

Die Korrelationsanalyse bleibt eines der wirkungsvollsten Instrumente, um Beziehungen zwischen Variablen zu erkennen und datenbasierte Entscheidungen zu treffen. In einer Zeit, in der Organisationen täglich große Datenmengen erzeugen, ist sie ein zentrales Werkzeug, um Strukturen sichtbar zu machen, Hypothesen zu prüfen und Muster zu verstehen. Ob in Marketing, Vertrieb, Projektmanagement oder Kundenservice, überall dort, wo Daten systematisch ausgewertet werden, liefert die Korrelationsanalyse entscheidende Einsichten.

Zentrale Erkenntnisse

Die Stärke der Methode liegt in ihrer Einfachheit und Klarheit. Sie zeigt, ob und wie stark zwei Variablen gemeinsam variieren, ohne komplizierte Modelle vorauszusetzen. Richtig angewendet kann sie helfen, Wirkungszusammenhänge zu erkennen, die später durch tiefere Analysen überprüft werden. Ebenso wichtig ist jedoch, ihre Grenzen zu kennen. Korrelation bedeutet keine Kausalität, und viele scheinbar klare Beziehungen können durch externe Faktoren beeinflusst werden.

- Korrelationen zeigen Beziehungen, aber keine Ursachen.

- Lineare Modelle erfassen nicht alle Zusammenhänge.

- Ausreißer und Datenqualität beeinflussen Ergebnisse stark.

- Die Interpretation ist nur im Kontext der Daten und Ziele sinnvoll.

Praktische Bedeutung für datengetriebene Unternehmen

Für moderne Unternehmen ist die Korrelationsanalyse weit mehr als eine statistische Methode. Sie ist ein Bestandteil datenorientierter Entscheidungsprozesse. Im Marketing ermöglicht sie, Budgets effizienter zu verteilen. Im Vertrieb hilft sie, Erfolgsfaktoren zu erkennen. Im Projektmanagement unterstützt sie die Risikobewertung, und im Kundenservice zeigt sie auf, welche Maßnahmen die Kundenzufriedenheit am stärksten beeinflussen.

Checkliste für die Berechnung der Korrelationsanalyse

Eine sorgfältige Berechnung ist die Grundlage jeder validen Korrelationsanalyse. Diese Liste hilft dabei, die wichtigsten Schritte methodisch und strukturiert zu durchlaufen.

Diese strukturierte Vorgehensweise stellt sicher, dass die Ergebnisse sowohl methodisch korrekt als auch nachvollziehbar sind. Die Berechnung ist nicht nur ein technischer Schritt, sondern eine Grundlage für die spätere Interpretation und Entscheidungsfindung.

Checkliste für die Implementierung auf Unternehmensebene

Damit die Korrelationsanalyse in einem Unternehmen echten Mehrwert schafft, muss sie in Prozesse, Systeme und Entscheidungsstrukturen eingebettet werden. Diese Checkliste hilft, die Einführung und Anwendung auf organisatorischer Ebene zu strukturieren.

Durch diese organisatorische Verankerung wird aus einer rein analytischen Berechnung ein Steuerungsinstrument für datengetriebene Entscheidungen. So können Unternehmen Muster frühzeitig erkennen und gezielt auf Veränderungen reagieren.

Ausblick: Die Zukunft der Korrelationsanalyse

Mit der zunehmenden Automatisierung und Verfügbarkeit großer Datenmengen verändert sich auch die Art, wie Korrelationen analysiert werden. Moderne Machine Learning Verfahren und Big Data Technologien erweitern die klassische Korrelationsanalyse um neue Dimensionen. Nichtlineare Modelle und datengetriebene Feature Analysen können Zusammenhänge identifizieren, die mit traditionellen Methoden verborgen bleiben.

Gleichzeitig steigt der Anspruch an Analystinnen und Analysten, Ergebnisse kritisch zu prüfen und nicht blind auf statistische Signale zu reagieren. Die Zukunft der Korrelationsanalyse liegt in der Kombination von Automatisierung und menschlicher Interpretation. Nur wenn analytische Präzision und Fachkompetenz zusammenwirken, wird Datenanalyse zu echter Entscheidungsintelligenz.

Schlussgedanke

Die Korrelationsanalyse ist mehr als eine statistische Methode. Sie ist ein Denkrahmen, der hilft, Daten nicht nur zu sehen, sondern zu verstehen. Wer sie sorgfältig, reflektiert und systematisch anwendet, kann aus Daten fundierte Entscheidungen ableiten. In einer datenorientierten Wirtschaft bleibt die Fähigkeit, Zusammenhänge zu erkennen und richtig zu deuten, eine der wertvollsten Kompetenzen jeder Organisation.

Quellen und Empfohlene Literatur zur Korrelationsanalyse

- Pearson’s Correlation Coefficient

- Correlation Coefficients: Appropriate Use and Interpretation.

- Interpretation of the Correlation Coefficient: A Basic Review

- Zhang, Y. et al. „R versus Python for Statistical Analysis: A Comparative Study.“ Expert Systems with Applications, 2021.

- Li, X. et al. „Extending classical correlation analysis to Big-Data environments.“ Pattern Recognition Letters, 2021.

- Dekimpe, M. „Nonlinear Effects in Marketing Budgets: Why simple linear correlation may mislead.“ International Journal of Research in Marketing, 2020.

- Rapp, A. et al. „Correlation and Sales Activities: A B2B Sales Process Analysis.“ Industrial Marketing Management, 2021.

- Epskamp, S. et al. „Network psychometrics and correlation structures.“ Journal of Memory and Language, 2019.

FAQs zur Korrelationsanalyse

Was ist eine Korrelationsanalyse?

Die Korrelationsanalyse ist ein statistisches Verfahren zur Messung der Stärke und Richtung eines Zusammenhangs zwischen zwei Variablen. Sie zeigt, ob Werte gemeinsam ansteigen oder fallen. Grundlage ist meist der Pearson Korrelationskoeffizient, der Werte zwischen -1 und +1 annehmen kann.

Welche Arten von Korrelationen gibt es?

Es gibt drei Hauptarten: positive Korrelation (beide Variablen steigen), negative Korrelation (eine steigt, die andere fällt) und keine Korrelation (kein Zusammenhang). Ergänzend dazu existieren nichtlineare Korrelationen, die komplexe Beziehungen abbilden.

Wie wird der Korrelationskoeffizient berechnet?

Der Korrelationskoeffizient r wird berechnet, indem die Kovarianz der Variablen durch das Produkt ihrer Standardabweichungen geteilt wird: r = Cov(X,Y) / (σX · σY). Dieses Maß ist dimensionslos und ermöglicht den Vergleich verschiedener Datensätze.

Was bedeutet ein Korrelationskoeffizient von 0,8?

Ein Korrelationskoeffizient von 0,8 zeigt eine starke positive Beziehung zwischen zwei Variablen. Das bedeutet, dass hohe Werte der einen Variablen meist mit hohen Werten der anderen einhergehen.

Was ist der Unterschied zwischen Korrelation und Kausalität?

Korrelation beschreibt nur den Zusammenhang zwischen Variablen, nicht aber Ursache und Wirkung. Eine hohe Korrelation kann auf einen indirekten Zusammenhang hinweisen, der durch eine Drittvariable verursacht wird.

Wann sollte die Spearman Korrelation verwendet werden?

Die Spearman Korrelation wird eingesetzt, wenn Daten nicht normalverteilt sind oder eine nichtlineare, monotone Beziehung vorliegt. Sie basiert auf Rangwerten statt auf absoluten Zahlen.

Wie können Ausreißer die Korrelationsanalyse beeinflussen?

Ausreißer können den Korrelationswert erheblich verzerren und zu falschen Schlussfolgerungen führen. Besonders in kleinen Stichproben kann ein einzelner Extremwert die Richtung der Korrelation verändern.

Wie wird die Signifikanz einer Korrelation geprüft?

Die Signifikanz wird durch einen t-Test überprüft, bei dem der berechnete Korrelationskoeffizient gegen den Nullhypothesenwert 0 getestet wird. Ein p-Wert unter 0,05 zeigt, dass die Korrelation statistisch signifikant ist.

Wie kann die Korrelationsanalyse in Unternehmen eingesetzt werden?

In Unternehmen dient die Korrelationsanalyse dazu, Zusammenhänge zwischen Kennzahlen zu erkennen, etwa zwischen Werbebudget und Umsatz, Kundenzufriedenheit und Loyalität oder Preis und Absatz.

Welche Software eignet sich für die Korrelationsanalyse?

Gängige Tools sind R, Python, SPSS und Excel. Für große Datensätze empfehlen sich Plattformen wie Apache Spark oder KNIME.

Was sind häufige Fehler bei der Interpretation der Korrelation?

Zu den häufigsten Fehlern zählen die Gleichsetzung von Korrelation und Kausalität, die Vernachlässigung von Ausreißern und die Überinterpretation schwacher Zusammenhänge.

Wie können nichtlineare Korrelationen erkannt werden?

Nichtlineare Korrelationen lassen sich durch Scatterplots, Rangkorrelationen oder Verfahren wie Mutual Information identifizieren. Diese Methoden erfassen gekrümmte oder komplexe Beziehungen.

Warum ist die Korrelationsanalyse in der datengetriebenen Wirtschaft wichtig?

In datengetriebenen Organisationen dient die Korrelationsanalyse als Frühwarnsystem für Chancen und Risiken. Sie zeigt, welche Kennzahlen sich gegenseitig beeinflussen, und unterstützt faktenbasierte Entscheidungen.