Predictive-Analytics ist ein leistungsstarkes Werkzeug, das Unternehmen dabei hilft, zukünftige Ereignisse vorherzusagen und fundierte Entscheidungen zu treffen.

In diesem Beitrag werden wir uns eingehend mit Predictive Analytics befassen, seine Definition, Funktionsweise, Vorteile und Modelle diskutieren. Wenn du zuerst die Basics von Marketing-Analytics – von Datenquellen bis Attributionsmodellen – verstehen möchtest, lies den Marketing-Analytics-Guide

Was ist Predictive-Analytics?

Predictive-Analytics ist eine fortschrittliche Disziplin, die statistische Algorithmen und Machine-Learning nutzt, um basierend auf historischen Daten zukünftige Ereignisse vorherzusagen. Als Teilbereich von Advanced-Analytics geht es dabei nicht nur um Reporting, sondern um Prognosen, Wahrscheinlichkeiten und bessere Entscheidungen.

Die Grundlage von Predictive Analytics liegt in der Analyse großer Datensätze, um Modelle zu entwickeln, die Prognosen für unterschiedlichste Szenarien ermöglichen. Diese Modelle erkennen Zusammenhänge zwischen variablen Faktoren und machen daraus Vorhersagen, die im Alltag planbar und nutzbar werden.

Im Detail betrachtet, zieht Predictive Analytics aus einer Vielzahl von Datenquellen Informationen heran, darunter soziale Medien, Transaktionsdaten, Kundeninteraktionen und mehr. Durch die Integration und Analyse dieser Daten können Unternehmen nicht nur potenzielle Entwicklungen antizipieren, sondern auch ihre Strategien systematisch optimieren.

- Datenbasis: Welche internen und externen Daten sind verfügbar und belastbar?

- Ziel: Was soll vorhergesagt werden (z. B. Nachfrage, Abwanderung, Risiko, Wert)?

- Modell: Welcher Modelltyp passt zur Frage (z. B. Klassifikation, Regression, Forecasting)?

- Aktivierung: Wie wird der Output in Prozesse übersetzt (z. B. Priorisierung, Automatisierung, Planung)?

- Kontrolle: Wie wird das Modell geprüft und aktuell gehalten, damit es dauerhaft verlässlich bleibt?

Die angewendeten Methoden reichen von klassischen statistischen Verfahren wie Regressionsanalysen und Entscheidungsbäumen bis hin zu komplexeren Ansätzen wie neuronalen Netzen und Random-Forests. Diese Vielfalt ermöglicht es, je nach Anwendungsfall passende Modelle zu wählen – von schnell erklärbar bis maximal leistungsfähig.

Die praktische Anwendung von Predictive Analytics erstreckt sich über diverse Branchen und Funktionen – von Marketing und Vertrieb über Finanzen bis hin zu Operations und Gesundheitswesen. Wenn du über die reine Vorhersage hinaus konkrete Handlungsempfehlungen ableiten willst, ist Prescriptive-Analytics der nächste logische Schritt.

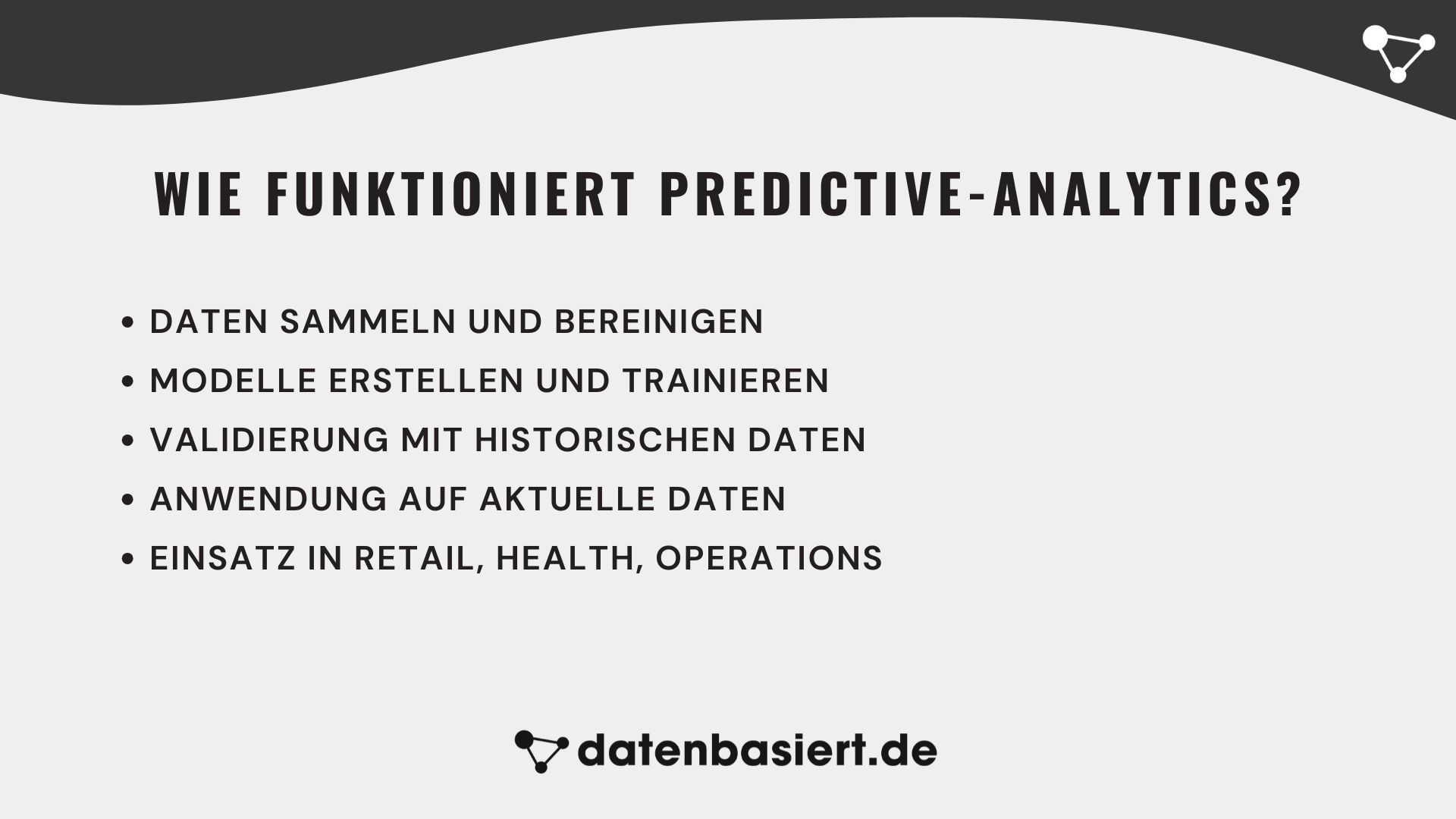

Wie funktioniert Predictive-Analytics?

Predictive-Analytics funktioniert durch die Analyse großer Datenmengen und die Anwendung statistischer Modelle und Algorithmen, um Muster zu erkennen und zukünftige Ereignisse vorherzusagen. Hier sind die Hauptschritte im Predictive Analytics-Prozess:

- Datenaufbereitung: Die Daten werden gesammelt, bereinigt und in ein Format gebracht, das für die Analyse geeignet ist. Dieser Schritt ist entscheidend, um sicherzustellen, dass die Datenqualität hoch ist und dass irrelevante oder fehlerhafte Daten entfernt werden.

- Modellbildung: Statistische Modelle und maschinelle Lernalgorithmen werden verwendet, um Vorhersagemodelle zu erstellen. Dazu gehören Techniken wie Regressionsanalysen, Entscheidungsbäume und künstliche neuronale Netze, die auf den spezifischen Datensatz und das Ziel der Vorhersage abgestimmt sind.

- Validierung: Die erstellten Modelle müssen gründlich getestet und validiert werden, um sicherzustellen, dass sie genaue Vorhersagen liefern. Dies wird oft durch die Verwendung von historischen Daten gemacht, die nicht in die Modellerstellung einbezogen wurden, um die Vorhersagegenauigkeit zu überprüfen.

- Anwendung: Die validierten Modelle werden schließlich auf aktuelle Daten angewendet, um Vorhersagen zu machen und Entscheidungen zu unterstützen. Die Ergebnisse können Unternehmen helfen, ihre zukünftigen Strategien zu optimieren und Risiken besser zu managen.

Predictive Analytics bietet eine Vielzahl von Anwendungsmöglichkeiten über verschiedene Branchen hinweg. In der Einzelhandelsbranche kann es beispielsweise verwendet werden, um Nachfrageprognosen zu erstellen und die Lagerbestände zu optimieren, um Engpässe zu vermeiden und gleichzeitig die Lagerhaltungskosten zu senken. Im Gesundheitswesen kann Predictive Analytics genutzt werden, um individuelle Patientenrisiken zu bewerten und personalisierte Behandlungspläne zu entwickeln, was zu einer verbesserten Patientenversorgung führt.

Die kontinuierliche Weiterentwicklung von Predictive Analytics wird durch Fortschritte in der Datenverarbeitungstechnologie und der Verfügbarkeit großer Datensätze vorangetrieben. Unternehmen, die diese Technologie einsetzen, können nicht nur wettbewerbsfähiger werden, sondern auch ihre Betriebsabläufe effizienter gestalten und Chancen für Innovationen erkennen. Erfahren Sie mehr über verwandte Themen wie Website-Optimierung und Conversion-Optimierung.

Die wichtigsten Modelle für Predictive-Analytics

Predictive-Analytics besteht nicht aus einem einzigen „Standard-Modell“, sondern aus unterschiedlichen Modelltypen, die jeweils eine andere Business-Frage beantworten. Manche Predictive-Analytics-Modelle helfen dir dabei, Entscheidungen zu priorisieren (z. B. welche Leads zuerst kontaktiert werden), andere sind stärker für Planung (z. B. Nachfrage, Ressourcen) oder Personalisierung (z. B. Empfehlungen) geeignet.

Wichtig ist dabei weniger, wie „smart“ ein Predictive-Analytics-Modell klingt, sondern ob es im Alltag handlungsfähig macht: Welche Aktion folgt aus dem Ergebnis? Wer nutzt den Output? Und wie stellst du sicher, dass das Modell auch dann noch passt, wenn sich Markt, Angebot oder Kundinnen und Kunden verändern? Genau deshalb lohnt es sich, die Modelltypen klar zu unterscheiden.

- Klassifizierungsmodelle

- Regressionsmodelle

- Clustering-Modelle

- Prognosemodelle (Forecasting für Kennzahlen)

- Zeitreihenmodelle

- Ausreisser- und Anomalieerkennungsmodelle

- Ensemble-Modelle (Random-Forest und Gradient-Boosting)

- Neuronale Netze und Deep-Learning

- Empfehlungsmodelle (Recommender-Systeme)

- Uplift-Modelle (Incrementality)

In den nächsten Unterkapiteln schauen wir uns jeden Predictive-Analytics-Modelltyp genauer an – mit Fokus auf Nutzen, typische Einsatzfelder, welche Art von Input du brauchst und welche Fehler in der Praxis am häufigsten passieren.

Klassifizierungsmodelle

Klassifizierungsmodelle beantworten Fragen wie „Ja oder Nein?“ oder „Welche Kategorie?“. In der Praxis geht es fast immer darum, eine Entscheidung zu erleichtern: Wen sollten wir zuerst ansprechen? Welche Fälle brauchen sofort Aufmerksamkeit? Welche Nutzerinnen und Nutzer sind wahrscheinlich an einem Angebot interessiert?

Der große Mehrwert entsteht, wenn du nicht nur eine Kategorie bekommst, sondern eine Art Priorisierung. So kannst du knappe Ressourcen (Sales, Support, Budget) dort einsetzen, wo die Wirkung am höchsten ist. Entscheidend ist dabei, dass du intern sauber definierst, was die Kategorien bedeuten – sonst optimierst du auf ein Ziel, das im Alltag niemand konsistent versteht.

- Typische Einsatzfelder: Lead-Priorisierung, Churn-Vermeidung, Betrugsverdacht, Ticket-Routing

- Typische Inputs: Verhalten (Klicks, Käufe), Historie, CRM-Daten, Interaktionen, Produktnutzung

- Output: Kategorie plus Priorität (z. B. „hoch, mittel, niedrig“)

- Praxis-Falle: Unklare Definitionen (was ist „Churn“?) und fehlende Regeln, was nach dem Ergebnis passiert

Damit Klassifizierungsmodelle wirklich helfen, brauchen sie eine klare Brücke zur Aktion: Welche Schwelle löst welche Massnahme aus? Und wie stellst du sicher, dass Teams dem Output vertrauen, statt ihn zu ignorieren? Ein guter Start ist immer ein kleiner Pilot mit klarer Prozessregel.

Regressionsmodelle

Regressionsmodelle sagen einen Zahlenwert voraus – zum Beispiel Umsatz, Bestellwert, Nachfrage oder Bearbeitungszeit. Das ist besonders nützlich, wenn du nicht nur wissen willst, ob etwas passiert, sondern wie stark es voraussichtlich wird.

In Unternehmen sind Regressionsmodelle oft der Motor für Planung und Steuerung: Budgets, Kapazitäten, Einkauf, Kampagnenplanung. Gleichzeitig ist wichtig, Regression nicht als „exakte Wahrheit“ zu verstehen, sondern als bestmögliche Schätzung. Gerade bei Planung sind „realistische Korridore“ oft wertvoller als eine einzelne Punktzahl.

- Typische Einsatzfelder: Umsatzplanung, Nachfrageplanung, Customer-Lifetime-Value, Forecast von Leads oder Tickets

- Typische Inputs: Historie, Preise, Kampagnen, Saisonalität, Produktmix, Kanal-Daten

- Output: erwarteter Wert, idealerweise ergänzt um „optimistisch, realistisch, konservativ“

- Praxis-Falle: Modelle werden für stabile Zeiten gebaut, aber nicht angepasst, wenn sich Markt und Angebot ändern

Regressionsmodelle liefern die grösste Wirkung, wenn du sie mit Entscheidungsregeln kombinierst – zum Beispiel Bestandsgrenzen, Budget-Stopps oder Prioritäten für Sales. So wird aus einer Zahl eine konkrete Steuerung.

Clustering-Modelle

Clustering-Modelle helfen dir dabei, Segmente zu entdecken, ohne dass du vorher Kategorien definieren musst. Du findest Gruppen, die sich im Verhalten oder Profil ähneln – zum Beispiel „Preisbewusste Vielkäufer“, „Gelegenheitskunden“ oder „Premium-Kundschaft“.

Der eigentliche Nutzen entsteht nicht durch die Cluster-Nummer, sondern durch die Interpretation: Was macht dieses Segment aus, welche Bedürfnisse hat es, und wie unterscheidet es sich vom Rest? Gute Cluster sind so beschrieben, dass Marketing, Vertrieb oder Produktteams damit arbeiten können – nicht nur Data-Teams.

- Typische Einsatzfelder: Kundensegmentierung, Produktgruppen, Zielgruppen für Kampagnen, Portfolio-Analysen

- Typische Inputs: Kaufhäufigkeit, Warenkorb, Kategorien, Nutzung, Interaktionsmuster

- Output: Segment-Zuordnung plus Segment-Beschreibung (Profil)

- Praxis-Falle: Segmente werden erstellt, aber nicht in Kampagnen, CRM oder Produktlogik integriert

Clustering funktioniert am besten, wenn du nach dem Finden der Segmente direkt in die Aktivierung gehst: eigene Botschaften, eigene Angebote, eigene Journeys. Und regelmässig prüfen, ob die Segmente stabil bleiben oder sich verschieben.

Prognosemodelle (Forecasting für Kennzahlen)

Forecasting-Modelle sind dafür da, Kennzahlen in die Zukunft zu planen – etwa Nachfrage, Conversions, Traffic oder Warenbedarf. Der Business-Wert ist klar: bessere Planung reduziert Kosten (zu viel Bestand, zu wenig Personal) und vermeidet verpasste Chancen (Out-of-Stock, überlasteter Support).

Viele Forecasts werden besser, wenn sie wichtige Einflussfaktoren berücksichtigen: Aktionen, Kampagnen, Feiertage, Preisänderungen, Wetter oder Lieferzeiten. So wird aus „die Zukunft wird wie die Vergangenheit“ ein Modell, das auch weiss, warum sich Zahlen verändern.

- Typische Einsatzfelder: Bestandsplanung, Personalplanung, Budgetplanung, Kampagnenprognosen

- Typische Inputs: historische Kennzahlen, Kalender-Effekte, Promotions, Preise, externe Einflüsse

- Output: Forecast pro Zeitraum, oft sinnvoll als Korridor (realistisch plus Puffer)

- Praxis-Falle: Forecasts werden erstellt, aber nicht systematisch mit echten Ergebnissen verglichen und verbessert

Forecasting wird dann richtig stark, wenn es als laufender Prozess gedacht ist: regelmässig nachschärfen, Abweichungen erklären, und den Forecast so bauen, dass Teams ihn als Entscheidungshilfe nutzen – nicht als Report, der nach zwei Wochen veraltet ist.

Zeitreihenmodelle

Zeitreihenmodelle sind besonders geeignet, wenn deine Daten stark von Wiederholungen geprägt sind – zum Beispiel Wochentage, Monatsanfänge, Ferienzeiten oder Saisonalität. Sie helfen, typische Muster zu erkennen und darauf aufbauend realistisch zu planen.

Im Alltag sind Zeitreihenmodelle oft die beste Wahl, wenn du regelmässige Peaks und Dellen hast – etwa im E-Commerce (Wochenende), im B2B (Monatsende) oder in Support-Volumen (nach Releases). Der Nutzen ist nicht nur die Vorhersage, sondern auch die Erklärung, welche wiederkehrenden Effekte es gibt.

- Typische Einsatzfelder: Traffic-Entwicklung, Sales pro Tag, Support-Volumen, Produktionsauslastung

- Typische Inputs: Zeitstempel, historische Werte, Kalender (Feiertage, Ferien), Events

- Output: Entwicklung über einen Horizont (z. B. nächste 30 Tage) plus erwartete Schwankungen

- Praxis-Falle: Ungewöhnliche Ereignisse (z. B. Sonderaktionen) werden nicht als solche markiert und verzerren die Muster

Zeitreihenmodelle wirken am stärksten, wenn du sie mit einem sauberen Kalender pflegst (Aktionen, Releases, Feiertage) und regelmässig prüfst, ob sich Muster geändert haben – zum Beispiel durch Sortiment, Preise oder neue Kanäle.

Ausreisser- und Anomalieerkennungsmodelle

Anomalieerkennung ist ein Frühwarnsystem: Sie entdeckt Auffälligkeiten, bevor ein Problem gross wird. Das kann ein plötzlicher Einbruch im Tracking sein, ungewöhnliche Umsätze, auffällige Transaktionen oder ein KPI, der sich „komisch“ verhält.

Wichtig ist dabei Kontext: Ein Umsatzpeak kann normal sein, wenn Sale ist – und kritisch, wenn kein Event läuft. Gute Anomalieerkennung arbeitet deshalb immer mit einer Idee von „Normalzustand“ und berücksichtigt, dass Normalität je nach Zeitraum, Kanal oder Segment unterschiedlich sein kann.

- Typische Einsatzfelder: Betrugsverdacht, KPI-Monitoring, Tracking-Fehler, System- und Prozess-Anomalien

- Typische Inputs: Transaktionen, KPI-Verläufe, Log-Daten, Systemevents, Kampagnenkalender

- Output: Auffälligkeits-Hinweis plus Priorität (was zuerst geprüft werden sollte)

- Praxis-Falle: Zu viele Alarme ohne klare Zuständigkeit führen dazu, dass Warnungen ignoriert werden

Der Schlüssel zum Erfolg ist nicht nur Erkennung, sondern Reaktion: Wer bekommt den Alert, wie schnell, und was ist die Standardmassnahme? Wenn das klar ist, wird Anomalieerkennung extrem wertvoll.

Ensemble-Modelle (Random-Forest und Gradient-Boosting)

Ensemble-Modelle kannst du dir wie „Teamwork“ vorstellen: Statt einer einzigen Logik kombinieren sie viele kleine Entscheidungslogiken. Das macht sie in der Praxis oft sehr zuverlässig, weil einzelne Schwächen sich gegenseitig ausgleichen.

Der grosse Vorteil im Unternehmensalltag: Ensemble-Modelle liefern häufig starke Ergebnisse, ohne dass du jede Beziehung im Detail erklären musst. Gleichzeitig kannst du meist trotzdem nachvollziehen, welche Faktoren den Ausschlag geben – was für Akzeptanz in Teams entscheidend ist.

- Typische Einsatzfelder: Churn, Lead-Priorisierung, Risiko-Scoring, Nachfrage-Schätzung

- Typische Inputs: gemischte Business-Daten (CRM, Web, Transaktionen, Produktnutzung)

- Output: Priorität oder Prognosewert, oft ergänzt um „wichtige Einflussfaktoren“

- Praxis-Falle: Starke Modelle werden gebaut, aber ohne Monitoring betrieben, bis sich das Verhalten ändert

Wenn du Ensemble-Modelle einsetzt, plane direkt den Betrieb mit: regelmässig prüfen, ob Ergebnisse stabil bleiben, und Stakeholdern erklären, wie man Output in Entscheidungen übersetzt. Dann werden Random-Forest und Gradient-Boosting zu echten Arbeitspferden.

Neuronale Netze und Deep-Learning

Deep-Learning spielt seine Stärken aus, wenn Daten unstrukturiert sind – zum Beispiel Texte (Support, Bewertungen), Bilder (Qualitätsprüfung), Audio oder sehr komplexe Nutzungsmuster. Hier ist der Mehrwert oft, dass das Modell aus Rohdaten nützliche Signale erkennen kann, ohne dass du alles manuell vorstrukturieren musst.

Im Unternehmenskontext lohnt sich Deep-Learning besonders, wenn du wirklich genug Daten hast und der Use-Case sonst schwer lösbar ist – oder wenn du Inhalte skalieren willst (z. B. automatische Klassifikation von Tickets, Erkennen wiederkehrender Themen, Content-Analyse). Es ist weniger ein „Standard-Tool“ für jede Tabelle, sondern eher ein Spezialwerkzeug für bestimmte Datentypen.

- Typische Einsatzfelder: Text-Auswertung, Ticket-Kategorisierung, Bildprüfung, Muster in Verhaltensdaten

- Typische Inputs: Texte, Bilder, Logs, Sequenzen von Nutzeraktionen

- Output: Kategorien, Prioritäten oder Zusammenfassungen, je nach Ziel

- Praxis-Falle: Erwartung „KI löst alles“, obwohl Datenbasis oder Prozesse nicht bereit sind

Deep-Learning wird dann wertvoll, wenn du es sauber in Prozesse einbaust: klare Qualitätsanforderungen, menschliche Kontrolle wo nötig, und ein realistischer Start mit einem konkreten Use-Case statt „alles auf einmal“.

Empfehlungsmodelle (Recommender-Systeme)

Recommender-Systeme haben ein einfaches Ziel: die richtige Empfehlung zur richtigen Zeit. Das kann ein Produkt, ein Content, ein Bundle oder der nächste Schritt in einer Journey sein. Der Nutzen liegt in besserer Orientierung, höherer Relevanz und oft auch in mehr Umsatz pro Besuch.

Damit Empfehlungen gut funktionieren, brauchst du nicht nur gute Logik, sondern auch gute Regeln: Was darf empfohlen werden (Verfügbarkeit, Marge, Jugendschutz), wie vermeidest du „immer das Gleiche“, und wie gehst du mit neuen Produkten oder neuen Nutzerinnen und Nutzern um? Gute Systeme kombinieren Personalisierung mit Business-Logik.

- Typische Einsatzfelder: Cross-Selling, Up-Selling, Content-Personalisierung, Merchandising

- Typische Inputs: Klicks, Käufe, Warenkörbe, Produktdaten, Inhalte, Nutzerprofile

- Output: Top-Empfehlungen als Liste oder Ranking

- Praxis-Falle: Empfehlungen werden nicht getestet, sondern „gefühlt“ bewertet

Am meisten bringt ein Recommender, wenn du ihn wie ein Produkt behandelst: testen, messen, verbessern. Dann siehst du schnell, ob er wirklich Mehrwert schafft – und für wen er am besten funktioniert.

Uplift-Modelle (Incrementality)

Uplift-Modelle gehen eine Ebene tiefer als klassische „Wer wird kaufen?“-Modelle. Sie fragen: Wer kauft wegen der Massnahme? Das ist wichtig, weil du sonst oft Budget an Menschen ausgibst, die ohnehin gekauft hätten – und damit Wirkung überschätzt.

Der Kern ist eine faire Gegenprobe: Du brauchst eine Gruppe, die eine Massnahme bekommt, und eine Vergleichsgruppe, die sie nicht bekommt. So erkennst du, ob E-Mail, Gutschein oder Retargeting wirklich zusätzlichen Effekt bringt – und bei welchen Segmenten sich der Einsatz lohnt.

- Typische Einsatzfelder: Gutschein-Strategie, Retargeting, CRM-Kampagnen, Angebots-Tests

- Typische Inputs: Kampagnendaten, Zielverhalten (Kauf, Anmeldung), Kundendaten, Vergleichsgruppen

- Output: Priorisierung: bei wem lohnt sich die Massnahme, bei wem nicht

- Praxis-Falle: Keine saubere Vergleichsgruppe, dadurch falsche Schlussfolgerungen zur Wirkung

Uplift-Modelle sind besonders wertvoll, wenn du Budget effizienter machen willst: weniger Streuverlust, weniger „Rabatt an alle“, mehr echte Wirkung. Voraussetzung ist, dass Tests und Messlogik im Unternehmen sauber aufgesetzt sind.

Tools für Predictive-Analytics

Für Predictive-Analytics brauchst du nicht nur gute Modelle, sondern auch ein Tool-Setup, das Daten, Analyse und Umsetzung sauber zusammenbringt. Denn selbst das beste Modell bringt wenig, wenn Datenquellen getrennt sind, Ergebnisse nicht verständlich aufbereitet werden oder die Übergabe in Marketing, Sales oder Operations fehlt.

Die gute Nachricht: Du musst nicht alles neu bauen. In den meisten Unternehmen entsteht ein funktionierender Predictive-Analytics-Stack aus einer Kombination aus Software, Programmiersprachen und Datenplattformen. Welche Mischung passt, hängt vor allem von Team-Skills, Datenlandschaft, Budget und dem gewünschten Automatisierungsgrad ab.

Software für Predictive-Analytics

Unter Software fallen sowohl klassische Analytics-Suiten als auch moderne Cloud-Plattformen. Sie helfen dir dabei, Daten aufzubereiten, Modelle zu erstellen und Ergebnisse so bereitzustellen, dass Fachbereiche damit arbeiten können.

Wichtig ist weniger, ob ein Tool alles kann, sondern ob es zu eurem Alltag passt: Wie schnell könnt ihr starten, wie gut lässt sich skalieren, und wie einfach ist die Zusammenarbeit zwischen Data-Team und Fachbereich?

- SAS (Statistical Analysis System): Eine umfassende Software-Suite für fortgeschrittene Analysen, die statistische Analysen, Datenmanagement und prädiktive Modellierung ermöglicht.

- IBM SPSS (Statistical Package for the Social Sciences): Ein leistungsstarkes statistisches Softwarepaket, das speziell für die Analyse von Daten und die Erstellung von Vorhersagemodellen entwickelt wurde.

- Microsoft Azure Machine Learning: Ein cloudbasierter Dienst, der Werkzeuge für Machine-Learning bietet, um Vorhersagemodelle zu erstellen und zu deployen.

- Amazon SageMaker: Eine Cloud-Plattform, die den gesamten Weg von Datenaufbereitung bis Deployment unterstützt und sich gut für skalierbare Use-Cases eignet.

- Google Vertex AI: Eine ML-Plattform in der Google Cloud, die Training, Bereitstellung und Betrieb von Modellen zentral bündelt.

- DataRobot: Eine Plattform, die den Aufbau und Vergleich von Modellen stark vereinfacht und häufig für schnelle Prototypen und Business-Teams genutzt wird.

- KNIME: Eine modulare Analytics-Plattform (Low-Code), mit der du Datenpipelines aufbauen und Predictive-Analytics-Workflows inkl. Modelltraining und Auswertung relativ schnell umsetzen kannst.

- Alteryx: Eine Plattform für Data-Preparation und Analytics, die sich besonders eignet, wenn Fachbereiche wiederholbare Predictive-Analytics-Prozesse (z. B. Scoring, Segmentierung, Forecasts) ohne viel manuellen Aufwand abbilden sollen.

Praxis-Tipp: Starte mit 1-2 realistischen Use-Cases (z. B. Lead-Priorisierung oder Nachfrageplanung) und wähle Tools danach aus, wie gut sie die Umsetzung in euren Prozess unterstützen – nicht nur nach Feature-Listen.

Programmiersprachen

Wenn du maximale Flexibilität willst oder eure Use-Cases sehr individuell sind, führen Programmiersprachen oft zu den besten Ergebnissen. Sie geben dir Kontrolle über Datenlogik, Modellierung und Integration in eure Systeme.

In der Praxis sind vor allem zwei Sprachen relevant, weil es dafür extrem viele Libraries, Beispiele und Community-Wissen gibt. Das macht es leichter, Teams aufzubauen und Lösungen langfristig zu pflegen.

- R: Eine Programmiersprache und Software-Umgebung für statistische Berechnungen und Grafiken. R ist besonders stark in der statistischen Analyse und bietet eine Vielzahl von Paketen für prädiktive Modellierung.

- Python: Eine vielseitige Programmiersprache, die sich durch ihre Einfachheit und Leistungsfähigkeit auszeichnet. Mit Bibliotheken wie Pandas, NumPy, SciPy und scikit-learn ist Python hervorragend für Datenanalyse und Machine-Learning geeignet.

Damit der Einsatz im Unternehmen funktioniert, lohnt sich eine klare Team-Routine: gemeinsame Standards (Naming, Dokumentation), saubere Übergaben (z. B. Notebooks -> produktiver Workflow) und eine einfache Art, Ergebnisse für Fachbereiche sichtbar zu machen.

Datenbanken

Predictive-Analytics lebt von Daten – und die müssen zuverlässig gespeichert, abrufbar und kombinierbar sein. Datenbanken sind deshalb die Basis, damit Modelle nicht mit Einmal-Exports, sondern mit stabilen Datenflüssen arbeiten können.

Welche Datenbank-Technologie sinnvoll ist, hängt davon ab, ob eure Daten eher strukturiert (z. B. Transaktionen), unstrukturiert (z. B. Events, Logs) oder sehr groß und verteilt sind. Wichtig ist vor allem, dass Datenzugriff und Datenqualität im Alltag gut funktionieren.

- SQL (Structured Query Language): Eine standardisierte Sprache zur Verwaltung und Abfrage relationaler Datenbanken. SQL-Datenbanken sind weit verbreitet und bieten zuverlässige und effiziente Datenmanagementlösungen.

- NoSQL: Datenbanken wie MongoDB, Apache Cassandra und Couchbase, die nicht-relationale Datenstrukturen verwenden. Sie sind besonders nützlich für die Verarbeitung unstrukturierter Daten und bieten hohe Skalierbarkeit und Flexibilität.

- Apache Hadoop: Ein Framework für die verteilte Speicherung und Verarbeitung großer Datensätze über Cluster von Computern. Hadoop ermöglicht es Unternehmen, massive Datenmengen zu analysieren und komplexe prädiktive Modelle zu erstellen.

In vielen Setups ist die Datenbank nicht nur Speicher, sondern Teil der Datenstrategie: klare Definitionen, konsistente IDs, und ein Datenmodell, das Analysen und Aktivierung (CRM, Kampagnen, Planung) wirklich unterstützt.

Weitere Plattformen und Tools

Zusätzlich zu Software, Programmiersprachen und Datenbanken gibt es Plattformen, die entweder besonders schnelle Verarbeitung ermöglichen oder die Ergebnisse besser in Reports und Dashboards bringen. Gerade wenn mehrere Teams beteiligt sind, wird dieser Layer wichtig.

Hier geht es oft um zwei Fragen: Wie schnell bekommt ihr Ergebnisse (z. B. nahezu in Echtzeit) – und wie gut können Fachbereiche die Resultate verstehen, prüfen und im Alltag nutzen?

- Big-Data-Plattformen: Technologien wie Apache Spark und Apache Flink bieten leistungsstarke Werkzeuge für die Echtzeit-Datenverarbeitung und -analyse.

- Cloud-basierte Lösungen: Anbieter wie Amazon Web Services (AWS), Google Cloud Platform (GCP) und Microsoft Azure bieten umfassende Cloud-Dienste, die Werkzeuge für Datenanalyse, Machine-Learning und prädiktive Modellierung umfassen.

- Business-Intelligence-Tools: Plattformen wie Tableau, Power BI und Qlik bieten fortschrittliche Visualisierungs- und Reporting-Funktionen, um Ergebnisse verständlich aufzubereiten.

Wenn du zusätzlich den KI-Kontext rund um Analytics und Marketing vertiefen willst, lies auch den Beitrag KI im Marketing.

Was sind Beispiele für Predictive-Analytics?

Predictive-Analytics wird in verschiedenen Branchen auf unterschiedliche Weise eingesetzt. Hier sind weitere Beispiele, die verdeutlichen, wie vielseitig diese Technologie angewendet werden kann:

- Marketing: Vorhersage von Kundenverhalten zur Personalisierung von Marketingkampagnen. Unternehmen nutzen Predictive-Analytics, um das Kaufverhalten von Kunden zu analysieren und maßgeschneiderte Marketingstrategien zu entwickeln, die die Kundenbindung und -zufriedenheit steigern.

- E-Commerce: Vorhersage von Kaufverhalten und personalisierte Produktempfehlungen. Online-Händler nutzen Predictive Analytics, um das Kaufverhalten von Kunden zu analysieren und individuelle Produktvorschläge zu machen, die die Conversion-Raten erhöhen.

- Finanzen: Bewertung des Kreditrisikos und Betrugserkennung. Banken und Finanzinstitutionen verwenden Predictive Analytics, um die Kreditwürdigkeit von Kunden zu bewerten und verdächtige Transaktionen zu identifizieren, die auf potenziellen Betrug hindeuten könnten.

- Gesundheitswesen: Vorhersage von Krankheitsausbrüchen und Patientenversorgung. Im Gesundheitswesen wird Predictive Analytics genutzt, um die Ausbreitung von Krankheiten zu prognostizieren, Ressourcen besser zu planen und individuelle Gesundheitspläne für Patienten zu erstellen, die auf ihren spezifischen Gesundheitsrisiken basieren.

- Produktion und Logistik: Optimierung der Lieferkette und Bestandsmanagement. Unternehmen verwenden Predictive Analytics, um Nachfrageprognosen zu erstellen und die Lieferketteneffizienz zu verbessern, indem sie genau planen, welche Produkte wo und wann benötigt werden.

- Personalwesen: Vorhersage von Mitarbeiterfluktuation und Talentmanagement. HR-Abteilungen setzen Predictive Analytics ein, um mögliche Abwanderungen von Mitarbeitern vorherzusagen und Strategien zu entwickeln, um talentierte Mitarbeiter zu halten und zu fördern.

- Immobilien: Bewertung von Immobilienpreisen und Marktanalyse. Immobilienmakler nutzen Predictive Analytics, um den Wert von Immobilien zu schätzen und Marktbedingungen zu analysieren, um fundierte Entscheidungen beim Kauf oder Verkauf von Immobilien zu treffen.

Die Anwendung von Predictive-Analytics in diesen Bereichen ermöglicht Unternehmen nicht nur, effizienter zu arbeiten, sondern auch strategische Vorteile zu erlangen, indem sie fundierte Entscheidungen auf der Grundlage von Daten treffen. Diese Technologie revolutioniert die Art und Weise, wie Geschäfte gemacht werden, und bietet Chancen für Innovation und Wachstum.

Was sind die Vorteile von Predictive-Analytics?

Predictive-Analytics bietet zahlreiche Vorteile für Unternehmen, die weit über die einfache Datenanalyse hinausgehen:

- Verbesserte Entscheidungsfindung: Einer der größten Vorteile von Predictive Analytics liegt in der Fähigkeit, fundierte Entscheidungen zu treffen. Durch die Analyse großer Datenmengen und die Erstellung präziser Vorhersagemodelle können Unternehmen besser verstehen, wie sich verschiedene Entscheidungen auf ihr Geschäft auswirken könnten. Dies ermöglicht es Managern und Führungskräften, strategische Entscheidungen auf Basis von Daten zu treffen, anstatt auf Intuition oder historische Erfahrungen angewiesen zu sein.

- Kosteneinsparungen: Predictive Analytics hilft Unternehmen, ihre Betriebskosten zu senken, indem sie Effizienzgewinne erzielen. Durch die Optimierung von Prozessen wie Inventarverwaltung, Personalplanung und Ressourcennutzung können Unternehmen genauere Prognosen über Bedarfe erstellen und Überbestände oder Unterdeckungen vermeiden. Dies führt zu reduzierten Lagerhaltungskosten, geringeren Betriebsausgaben und insgesamt effizienteren Geschäftsabläufen.

- Wettbewerbsvorteil: Unternehmen, die Predictive Analytics erfolgreich einsetzen, können einen signifikanten Wettbewerbsvorteil erlangen. Indem sie schneller auf Marktveränderungen reagieren, Trends vorhersagen und Kundenbedürfnisse antizipieren können, positionieren sie sich besser im Markt. Dies ermöglicht es ihnen nicht nur, ihre bestehenden Kunden besser zu bedienen, sondern auch neue Marktchancen zu identifizieren und zu nutzen, bevor ihre Wettbewerber dies tun.

- Kundenerfahrung: Ein weiterer bedeutender Vorteil von Predictive Analytics liegt in der Verbesserung der Kundenerfahrung. Durch die Analyse von Kundenverhalten und Präferenzen können Unternehmen personalisierte Angebote und Empfehlungen erstellen, die besser auf die individuellen Bedürfnisse und Wünsche ihrer Kunden zugeschnitten sind. Dies führt zu einer höheren Kundenzufriedenheit, stärkeren Kundenbindungen und letztlich zu einer Steigerung der Umsätze und Gewinne.

- Risikomanagement: Predictive Analytics unterstützt Unternehmen auch beim Risikomanagement, indem es potenzielle Risiken und Bedrohungen frühzeitig identifiziert. Ob es um die Bewertung von Kreditrisiken in der Finanzbranche geht oder um die Vorhersage von Produktionsausfällen in der Fertigungsindustrie, die Fähigkeit, Risiken präzise zu prognostizieren, ermöglicht es Unternehmen, rechtzeitig Gegenmaßnahmen zu ergreifen und potenzielle Schäden zu minimieren.

Die Implementierung von Predictive Analytics erfordert oft eine Kombination aus fortgeschrittenen Analysetechniken, maschinellem Lernen und einer robusten Dateninfrastruktur. Unternehmen, die in diese Technologie investieren, können jedoch langfristige Vorteile in Form von verbesserten Geschäftsergebnissen und einer gesteigerten Wettbewerbsfähigkeit erzielen.

Erfahren Sie mehr darüber, wie Predictive Analytics Ihr Unternehmen transformieren kann, indem Sie unseren Beitrag über Marketing Automation lesen und herausfinden, wie diese Technologie Ihre Marketingstrategien revolutionieren kann.

Wie implementiert man Predictive Analytics im Unternehmen?

Die Implementierung von Predictive Analytics in einem Unternehmen erfordert sorgfältige Planung und Durchführung. Hier sind die wichtigsten Schritte, die Unternehmen befolgen sollten, um erfolgreich prädiktive Analysen zu integrieren:

- Bedarfsanalyse: Ermittlung der spezifischen Geschäftsanforderungen und Ziele. Der erste Schritt besteht darin, die genauen Bedürfnisse des Unternehmens zu verstehen und die Ziele der Predictive Analytics-Initiative zu definieren. Dies kann die Identifizierung von Geschäftsbereichen umfassen, in denen Vorhersagemodelle am meisten Nutzen bringen, wie z.B. Vertrieb, Marketing, Risikomanagement oder Lieferkettenoptimierung.

- Datenintegration: Zusammenführung und Bereinigung von Daten aus verschiedenen Quellen. Predictive Analytics erfordert qualitativ hochwertige und konsistente Daten. Dies beinhaltet die Integration von Daten aus unterschiedlichen Systemen und Quellen, wie CRM-Systeme, ERP-Systeme, soziale Medien und IoT-Geräte. Datenbereinigung ist ebenfalls ein kritischer Schritt, um sicherzustellen, dass die Daten frei von Fehlern und Inkonsistenzen sind, die die Genauigkeit der Modelle beeinträchtigen könnten.

- Modellentwicklung: Erstellung und Training von Vorhersagemodellen. In dieser Phase werden statistische Modelle und Algorithmen des maschinellen Lernens entwickelt und trainiert. Datenwissenschaftler nutzen Programmiersprachen wie Python oder R und spezielle Softwaretools, um Modelle zu erstellen, die zukünftige Ereignisse auf der Grundlage historischer Daten vorhersagen können. Es ist wichtig, die richtigen Algorithmen zu wählen, die den spezifischen Anforderungen des Unternehmens entsprechen.

- Ergebnisse validieren: Überprüfung und Validierung der Vorhersagen. Nach der Entwicklung der Modelle müssen diese gründlich getestet und validiert werden, um ihre Genauigkeit und Zuverlässigkeit zu gewährleisten. Dies wird durch die Verwendung von Testdatensätzen und die Durchführung von Modellvalidierungstechniken wie Kreuzvalidierung erreicht. Die Ergebnisse werden mit tatsächlichen Ergebnissen verglichen, um die Vorhersageleistung zu bewerten und das Modell bei Bedarf anzupassen.

- Implementierung und Einsatz: Sobald die Modelle validiert sind, können sie in die Produktionsumgebung integriert werden. Dies kann die Einbettung der Modelle in bestehende Unternehmenssysteme oder die Entwicklung neuer Anwendungen umfassen, die auf den Vorhersagen basieren. Es ist wichtig, einen nahtlosen Übergang sicherzustellen, um die Kontinuität der Geschäftsprozesse zu wahren.

- Überwachung und Wartung: Kontinuierliche Überwachung und Wartung der Vorhersagemodelle sind unerlässlich, um ihre Leistung im Laufe der Zeit zu gewährleisten. Daten und Geschäftsanforderungen ändern sich ständig, daher müssen die Modelle regelmäßig überprüft und aktualisiert werden, um ihre Genauigkeit und Relevanz zu erhalten. Dies kann die Anpassung der Modelle an neue Daten oder die Einführung neuer Algorithmen umfassen.

- Schulung und Akzeptanz: Um den vollen Nutzen aus Predictive Analytics zu ziehen, müssen Mitarbeiter geschult und mit den neuen Tools und Prozessen vertraut gemacht werden. Dies fördert die Akzeptanz und Nutzung der prädiktiven Analysen im gesamten Unternehmen. Schulungen können Workshops, Seminare und Schulungsprogramme umfassen, die speziell auf die Bedürfnisse der verschiedenen Abteilungen zugeschnitten sind.

Die erfolgreiche Implementierung von Predictive Analytics kann erhebliche Vorteile für Unternehmen bringen, einschließlich verbesserter Entscheidungsfindung, Kosteneinsparungen und Wettbewerbsvorteilen. Es erfordert jedoch eine sorgfältige Planung und Ausführung, um sicherzustellen, dass die Vorhersagemodelle genau und zuverlässig sind.

Für weitere Details zur erfolgreichen Implementierung und zur Förderung einer Datenkultur in Ihrem Unternehmen, lesen Sie unseren Artikel über Datenkultur. Hier erfahren Sie, wie Sie Ihr Unternehmen auf die Integration von Predictive Analytics vorbereiten und den langfristigen Erfolg sicherstellen können.

Datenquellen und Datenmanagement-Strategien für Predictive-Analytics

Die Qualität und Verfügbarkeit der Daten sind entscheidend für den Erfolg von Predictive Analytics. Die richtigen Datenquellen und effektive Datenmanagement-Strategien sind unerlässlich, um präzise und zuverlässige Vorhersagen zu erstellen. Hier sind wichtige Datenquellen und Strategien:

- Interne Daten: Interne Datenquellen sind die Grundlage für viele prädiktive Modelle, da sie spezifische Informationen über das Unternehmen und seine Abläufe liefern.

- Verkaufsdaten: Diese Daten umfassen Informationen über Verkäufe, Umsatz, Kundenkäufe und -verhalten. Verkaufsdaten helfen, Trends und Muster im Kaufverhalten zu identifizieren, die für die Vorhersage zukünftiger Verkaufszahlen genutzt werden können.

- Kundendaten: Informationen über Kunden, wie demografische Daten, Kaufhistorie, Interaktionen und Feedback, sind entscheidend für die Personalisierung von Marketingkampagnen und die Verbesserung der Kundenerfahrung.

- Betriebsdaten: Diese Daten umfassen Informationen über Produktionsprozesse, Lieferketten, Lagerbestände und Betriebskosten. Betriebsdaten ermöglichen es Unternehmen, ihre Effizienz zu steigern und Kosten zu senken, indem sie Engpässe und ineffiziente Prozesse identifizieren.

Interne Daten sind oft leicht zugänglich und können schnell in prädiktive Modelle integriert werden. Sie bieten wertvolle Einblicke in die internen Abläufe und die Leistung des Unternehmens. Durch die systematische Erfassung und Analyse dieser Daten können Unternehmen fundierte Entscheidungen treffen und ihre Geschäftsstrategien optimieren.

- Externe Daten: Externe Datenquellen ergänzen interne Daten und bieten wertvolle Einblicke in Markttrends, Wettbewerbslandschaften und externe Faktoren, die das Geschäft beeinflussen können.

- Marktdaten: Informationen über Markttrends, Branchendaten, Wettbewerber und wirtschaftliche Indikatoren helfen Unternehmen, ihre Position im Markt zu verstehen und strategische Entscheidungen zu treffen.

- Soziale Medien: Daten aus sozialen Netzwerken bieten Einblicke in Kundenmeinungen, Trends und Stimmungen. Durch die Analyse von Social-Media-Daten können Unternehmen die öffentliche Wahrnehmung ihrer Marke verbessern und gezielte Marketingstrategien entwickeln.

- Öffentliche Datenquellen: Daten aus öffentlichen Quellen, wie Regierungsberichte, Statistiken und Wetterdaten, können wichtige externe Faktoren liefern, die Einfluss auf Geschäftsentscheidungen haben.

Externe Daten können das Verständnis für den Markt und die Umgebung, in der das Unternehmen tätig ist, erheblich verbessern. Sie ermöglichen es Unternehmen, sich an Marktveränderungen anzupassen und wettbewerbsfähig zu bleiben. Die Kombination von internen und externen Daten schafft eine umfassendere Datenbasis, die zu präziseren Vorhersagen führt.

- Datenmanagement: Effektives Datenmanagement ist entscheidend für die Nutzung von Predictive Analytics. Es umfasst mehrere Schlüsselbereiche:

- Datenbereinigung: Daten müssen bereinigt werden, um Fehler, Duplikate und Inkonsistenzen zu entfernen. Dies ist entscheidend, um sicherzustellen, dass die Daten genau und zuverlässig sind, was die Qualität der Vorhersagen verbessert.

- Datenintegration: Daten aus verschiedenen Quellen müssen integriert werden, um eine umfassende und kohärente Datenbasis zu schaffen. Dies ermöglicht es Unternehmen, umfassende Analysen durchzuführen und fundierte Entscheidungen zu treffen.

- Datenqualität: Die Sicherstellung der Datenqualität ist entscheidend für die Genauigkeit der Vorhersagemodelle. Dies umfasst die Überprüfung der Daten auf Vollständigkeit, Konsistenz und Relevanz.

- Datenarchitektur: Eine robuste Datenarchitektur, die die Speicherung, Verwaltung und den Zugriff auf Daten effizient unterstützt, ist notwendig. Dies kann Cloud-basierte Lösungen oder lokale Datenbanken umfassen, abhängig von den spezifischen Anforderungen des Unternehmens.

- Datenzugang und -sicherheit: Der Zugang zu Daten sollte kontrolliert und sicher sein, um den Schutz sensibler Informationen zu gewährleisten. Dies beinhaltet die Implementierung von Zugriffskontrollen, Verschlüsselung und anderen Sicherheitsmaßnahmen, um Daten vor unbefugtem Zugriff und Cyber-Bedrohungen zu schützen.

Ein robustes Datenmanagement-System ist unerlässlich, um die Integrität und Verfügbarkeit der Daten zu gewährleisten. Unternehmen müssen sicherstellen, dass ihre Daten sicher, zugänglich und gut organisiert sind, um die Genauigkeit und Effizienz ihrer prädiktiven Analysen zu maximieren.

Durch die Kombination interner und externer Datenquellen und die Implementierung effektiver Datenmanagement-Strategien können Unternehmen die Genauigkeit und Zuverlässigkeit ihrer prädiktiven Modelle maximieren. Eine sorgfältige Planung und Durchführung dieser Schritte ist entscheidend, um den vollen Nutzen von Predictive Analytics zu realisieren und fundierte, datengestützte Entscheidungen zu treffen.

Mehr Informationen zu effizienten Datenstrategien und deren Bedeutung für die Nutzung von Predictive Analytics finden Sie in unserem Beitrag über datenbasiertes Marketing. Hier erfahren Sie, wie eine effektive Datenstrategie die Marketingeffizienz und den Geschäftserfolg steigern kann.

Was ist der Unterschied zwischen Predictive und Prescriptive Analytics?

Predictive Analytics und Prescriptive Analytics sind beide wichtige Analysemethoden im Bereich Advanced-Analytics. Sie unterscheiden sich jedoch erheblich in ihrem Ansatz, ihren Zielen und ihrer Anwendung. Während beide Methoden wertvolle Einblicke bieten, liegt ihr Schwerpunkt auf unterschiedlichen Aspekten der Entscheidungsfindung.

- Predictive Analytics: Predictive Analytics nutzt historische Daten, um zukünftige Ereignisse vorherzusagen. Diese Methode konzentriert sich darauf, Muster und Trends in den Daten zu erkennen und daraus Vorhersagen über zukünftige Entwicklungen abzuleiten.

- Predictive Analytics verwendet verschiedene statistische Modelle und maschinelle Lernalgorithmen, um die Wahrscheinlichkeit zukünftiger Ereignisse zu berechnen.

- Typische Anwendungen umfassen die Vorhersage von Verkaufszahlen, die Ermittlung von Kundenabwanderungsraten und die Prognose von Nachfrage in verschiedenen Märkten.

- Durch die Nutzung von Predictive Analytics können Unternehmen proaktive Maßnahmen ergreifen, um auf vorhergesagte Entwicklungen vorbereitet zu sein und entsprechende Strategien zu entwickeln.

- Prescriptive Analytics: Prescriptive Analytics geht einen Schritt weiter als Predictive Analytics, indem es nicht nur Vorhersagen macht, sondern auch konkrete Handlungsempfehlungen auf der Grundlage dieser Vorhersagen gibt.

- Prescriptive Analytics verwendet Optimierungsalgorithmen, Simulationen und Entscheidungsregeln, um die besten Maßnahmen für eine bestimmte Situation zu bestimmen.

- Es berücksichtigt verschiedene Szenarien und mögliche Ergebnisse, um Empfehlungen zu geben, die den größten Nutzen oder die geringsten Risiken bieten.

- Beispiele für Anwendungen sind die Optimierung von Lieferketten, die Planung von Wartungsarbeiten und die Erstellung personalisierter Marketingkampagnen.

- Prescriptive Analytics kann auch komplexe Entscheidungen unterstützen, indem es verschiedene Optionen bewertet und die optimale Strategie vorschlägt.

Der Hauptunterschied zwischen den beiden Methoden liegt also in ihrem Fokus: Predictive Analytics sagt voraus, was passieren könnte, während Prescriptive Analytics Empfehlungen gibt, was zu tun ist, um ein bestimmtes Ziel zu erreichen oder ein Problem zu lösen.

Predictive Analytics bietet eine Grundlage für datengestützte Vorhersagen und hilft Unternehmen, sich auf zukünftige Entwicklungen vorzubereiten. Prescriptive Analytics ergänzt dies, indem es konkrete Anweisungen zur Umsetzung gibt und somit den Entscheidungsprozess unterstützt.

Die Integration beider Analysemethoden kann Unternehmen erheblich dabei helfen, nicht nur die Zukunft besser zu verstehen, sondern auch optimal darauf zu reagieren. Während Predictive Analytics auf Erkenntnissen und Wahrscheinlichkeiten basiert, sorgt Prescriptive Analytics dafür, dass diese Erkenntnisse in praktische, wertschöpfende Maßnahmen umgesetzt werden.

Erfahren Sie mehr über Prescriptive Analytics und wie es Ihrem Unternehmen helfen kann, datengetriebene Entscheidungen zu treffen und effektive Strategien zu entwickeln, auf unserer Seite Prescriptive Analytics.

Was sind die Zukunftstrends in Predictive-Analytics?

Predictive-Analytics entwickelt sich ständig weiter und neue Trends entstehen, die die Art und Weise, wie Unternehmen Daten analysieren und nutzen, revolutionieren. Hier sind einige der bedeutendsten Zukunftstrends in diesem Bereich:

- Künstliche Intelligenz (KI): Die Integration von künstlicher Intelligenz in Predictive Analytics wird immer tiefer und ausgefeilter.

- Verbesserte Algorithmen: Fortschritte in der KI, insbesondere im Bereich des maschinellen Lernens und der tiefen neuronalen Netze, ermöglichen präzisere und schnellere Vorhersagen.

- Automatisierung: KI kann den Analyseprozess automatisieren, wodurch weniger manuelle Eingriffe erforderlich sind und die Effizienz gesteigert wird.

- Selbstlernende Systeme: Durch kontinuierliches Lernen und Anpassung an neue Daten können KI-basierte Systeme ihre Vorhersagegenauigkeit im Laufe der Zeit verbessern.

- Echtzeit-Analysen (Real-Time-Analytics): Die Nachfrage nach sofortiger Datenverarbeitung und Vorhersagen nimmt zu, insbesondere in dynamischen und schnelllebigen Branchen.

- Stream-Processing-Technologien: Diese Technologien ermöglichen die Verarbeitung und Analyse von Datenströmen in Echtzeit, was Unternehmen erlaubt, sofort auf Veränderungen zu reagieren.

- Realtime-Dashboards: Interaktive Dashboards bieten Echtzeit-Einblicke, die Entscheidungsträgern helfen, fundierte und zeitnahe Entscheidungen zu treffen.

- Automatisierte Entscheidungen: Systeme, die in der Lage sind, automatisch auf Echtzeit-Daten zu reagieren und Entscheidungen zu treffen, ohne menschliches Eingreifen.

- Erweiterte Datenquellen: Die Nutzung von Daten aus neuen und vielfältigen Quellen eröffnet zusätzliche Möglichkeiten für tiefere und umfassendere Analysen.

- Internet der Dinge (IoT): Daten von vernetzten Geräten liefern wertvolle Einblicke in Echtzeit, die für Predictive Analytics genutzt werden können. Beispiele sind Sensordaten aus Maschinen, Fahrzeuge und Smart-Home-Geräte.

- Soziale Medien und Webdaten: Informationen aus sozialen Netzwerken, Blogs und anderen Online-Plattformen bieten Einblicke in Verbrauchertrends und öffentliche Meinungen.

- Geodaten: Standortbezogene Daten ermöglichen die Analyse von Bewegungsmustern und geografischen Trends, was besonders für Einzelhandel und Logistik von Bedeutung ist.

Die kontinuierliche Weiterentwicklung in diesen Bereichen führt zu immer leistungsfähigeren und nützlicheren Analysetools, die Unternehmen helfen, ihre Geschäftsstrategien zu optimieren und wettbewerbsfähig zu bleiben. Mit der zunehmenden Verfügbarkeit von Daten und den fortschreitenden Technologien wird Predictive Analytics immer mehr zur Grundlage datengesteuerter Entscheidungsprozesse.

Ein weiterer spannender Bereich ist die Integration von Predictive Analytics in personalisierte Kundenerfahrungen. Unternehmen nutzen diese Technologie, um personalisierte Marketingkampagnen zu erstellen, die Kundenbindung zu erhöhen und den Umsatz zu steigern.

Bleiben Sie auf dem Laufenden über die neuesten Entwicklungen und wie sie Ihre Marketingstrategien verbessern können, indem Sie unseren Artikel über KI im Marketing lesen. Hier erfahren Sie mehr über die innovativen Anwendungen von KI und Predictive Analytics im modernen Marketing.

Fazit

Predictive-Analytics hilft Unternehmen, bessere Entscheidungen zu treffen, weil es aus vorhandenen Daten konkrete Vorhersagen und Prioritäten ableitet – von Nachfrage und Umsatz bis hin zu Churn, Risiken oder personalisierten Empfehlungen. Der größte Hebel entsteht dort, wo die Ergebnisse nicht nur analysiert, sondern in Prozesse übersetzt werden: als klare nächste Schritte für Marketing, Sales, Operations oder Finance.

Damit Predictive-Analytics langfristig wirkt, braucht es weniger „perfekte Modelle“ als eine saubere Datenbasis, passende Tools und ein realistisches Vorgehen in kleinen, messbaren Use-Cases. Wer zusätzlich nicht nur wissen will, was wahrscheinlich passiert, sondern auch welche Maßnahme sich am meisten lohnt, kann den nächsten Schritt Richtung Prescriptive-Analytics gehen.

Quellen und empfohlene Ressourcen

Die folgenden wissenschaftlichen Quellen vertiefen das Thema Predictive-Analytics – von Grundlagen und Qualitätsfragen über Modell- und Framework-Themen bis hin zu konkreten Anwendungsfeldern.

Alle Ressourcen sind fachlich nah am Blogartikel und eignen sich als weiterführende Lektüre für Teams, die Predictive-Analytics in der Praxis sauber aufsetzen und bewerten wollen.

- Predictive analytics in health care: how can we know it works? (2019) – PubMed

- Predictive Analytics: A Review of Trends and Techniques (2018) – International Journal of Computer Applications

- Computationally and Memory-Efficient Robust Predictive Analytics Using Big Data (2024) – arXiv

- Towards reliable predictive analytics: a generalized calibration framework (2023) – arXiv

- Predicting Practically? Domain Generalization for Predictive Analytics in Real-world Environments (2025) – arXiv

- A Unified and Fast Interpretable Model for Predictive Analytics (2021) – arXiv

- Predictive analytics using Social Big Data and machine learning (2021) – arXiv

- Beyond Public Health Genomics: Can Big Data and Predictive Analytics Deliver Precision Public Health? (2018) – PubMed

- Towards a Domain-Specific Framework for Predictive Analytics in Manufacturing (2014) – NIST (PDF)

- Investigating Grey-Box Modeling for Predictive Analytics in Smart Manufacturing (2017) – NIST

- Predictive Analytics for Semi-structured Case Oriented Business Processes (2010) – SpringerLink

- Predictive Analytics (Encyclopedia Entry) (2018) – SpringerLink

FAQs zu Predictive-Analytics

Was ist Predictive-Analytics?

Predictive-Analytics ist die datenbasierte Vorhersage zukünftiger Ereignisse oder Verhaltensweisen anhand historischer Daten. Ziel ist, Entscheidungen zu verbessern, Risiken früher zu erkennen und Chancen gezielt zu nutzen.

Was bedeutet Predictive Analytics auf Deutsch?

Predictive Analytics bedeutet auf Deutsch meist prädiktive Analytik oder Vorhersageanalyse. Gemeint ist die Prognose von zukünftigen Entwicklungen mit Daten und statistischen Verfahren.

Welche Beispiele gibt es für Predictive-Analytics?

Typische Predictive-Analytics Beispiele sind Churn-Prognosen, Nachfrageprognosen, Betrugserkennung, Lead-Priorisierung, Personalplanung sowie Produktempfehlungen im E-Commerce.

Welche Modelle werden bei Predictive-Analytics genutzt?

Häufige Predictive-Analytics Modelle sind Klassifizierungsmodelle, Regressionsmodelle, Zeitreihen- und Forecasting-Modelle, Clustering-Modelle, Anomalieerkennung sowie Empfehlungsmodelle.

Wie funktioniert Predictive-Analytics?

Predictive-Analytics folgt meist einem Ablauf aus Daten sammeln, Daten bereinigen, Modell erstellen, Modell testen und anschließend Vorhersagen in Prozesse einbauen. Der Nutzen entsteht, wenn aus dem Ergebnis konkrete Aktionen abgeleitet werden.

Welche Daten braucht man für Predictive-Analytics?

Je nach Use-Case brauchst du meist interne Daten wie CRM-, Transaktions-, Web- oder Produktnutzungsdaten. Externe Daten wie Markt- oder Wetterdaten können Vorhersagen zusätzlich verbessern, wenn sie relevant sind.

Welche Vorteile hat Predictive-Analytics für Unternehmen?

Predictive-Analytics verbessert Entscheidungen, reduziert Kosten durch bessere Planung, steigert Umsätze durch Priorisierung und Personalisierung und unterstützt Risikomanagement, zum Beispiel bei Fraud oder Ausfällen.

Welche Nachteile oder Risiken hat Predictive-Analytics?

Häufige Risiken sind schlechte Datenqualität, verzerrte Ergebnisse durch einseitige Daten, fehlende Akzeptanz im Team und veraltete Modelle bei veränderten Rahmenbedingungen. Auch Datenschutz und Governance sollten früh geklärt werden.

Was ist der Unterschied zwischen Predictive-Analytics und Prescriptive-Analytics?

Predictive-Analytics beantwortet die Frage, was wahrscheinlich passieren wird. Prescriptive-Analytics geht weiter und hilft zu entscheiden, welche Maßnahme sinnvoll ist, um ein Ziel zu erreichen oder Risiken zu senken.

Welche Tools gibt es für Predictive-Analytics?

Für Predictive-Analytics werden häufig Kombinationen aus Software-Plattformen, Programmiersprachen wie Python oder R und Datenplattformen genutzt. Entscheidend ist, dass Tools Analyse und Aktivierung im Alltag unterstützen.

Wie startet man mit Predictive-Analytics im Unternehmen?

Starte mit einem klaren Use-Case, definiere Erfolgskriterien, nutze verfügbare Daten und teste das Vorgehen in einem kleinen Pilot. Danach folgt die Integration in Prozesse, plus laufendes Monitoring und Verbesserung.

Wie misst man, ob Predictive-Analytics funktioniert?

Neben Prognosequalität zählt die Business-Wirkung: zum Beispiel weniger Churn, geringere Kosten, höhere Conversion oder bessere Planung. Wichtig ist der Vergleich gegen eine Baseline, etwa vorherige Prozesse oder kontrollierte Tests.