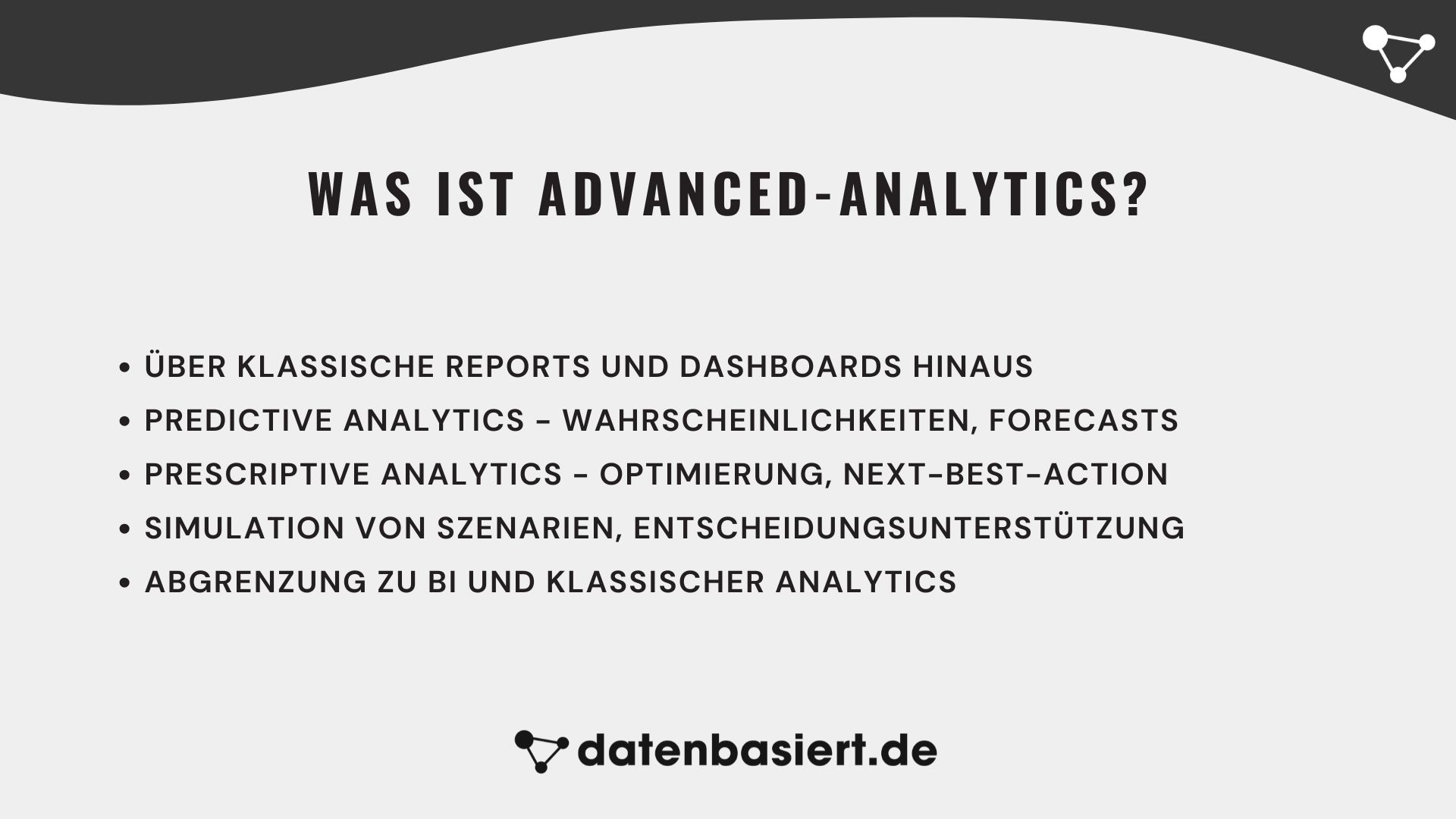

Advanced-Analytics geht über klassische Reports und Dashboards hinaus: Statt nur zu beschreiben, was passiert ist, nutzt es statistische Modelle und Machine Learning, um Verhalten vorherzusagen und um Szenarien zu simulieren.

In diesem Artikel zeige ich Ihnen, welche Formen von Advanced-Analytics es gibt, wie solche Modelle technisch grob funktionieren und in welchen typischen Anwendungsfällen sie im Marketing und darüber hinaus echten Mehrwert bringen.

Für ein Gefühl dafür, wie Advanced-Analytics zusammen mit Tracking, Events und Kennzahlen das große Ganze im Marketing-Analytics ergibt, wirf einen Blick in unseren Marketing-Analytics-Guide.

Was ist Advanced-Analytics?

Advanced-Analytics ist ein fortgeschrittener Ansatz zur Datenanalyse, der über die traditionellen Methoden hinausgeht. Es beinhaltet die Verwendung komplexer Techniken und Tools, um tiefergehende Einblicke in Daten zu gewinnen und zukünftige Ereignisse vorherzusagen.

Während klassische Analytics sich hauptsächlich auf deskriptive Statistiken und die Analyse vergangener Daten konzentriert, zielt Advanced-Analytics darauf ab, zukünftige Trends und Verhaltensmuster vorherzusagen.

Definition von Advanced-Analytics

Advanced-Analytics umfasst eine Vielzahl von Methoden, einschließlich maschinellem Lernen, statistischen Modellen, Data Mining, Predictive und Prescriptive-Analytics. Es geht darum, große Datenmengen zu analysieren und Muster zu erkennen, die mit traditionellen Methoden schwer zu identifizieren sind. Diese fortschrittlichen Techniken ermöglichen es, tiefere Einblicke zu gewinnen und fundierte Vorhersagen zu treffen.

Im Gegensatz zu einfachen Datenanalysen, die sich auf die Aufbereitung und Darstellung von Daten beschränken, zielt Advanced-Analytics darauf ab, zukünftige Entwicklungen vorherzusagen und Handlungsempfehlungen zu geben. Es wird in vielen Branchen eingesetzt, darunter Finanzen, Gesundheitswesen, Marketing und Logistik, um nur einige zu nennen.

Ziele von Advanced-Analytics

Das Hauptziel von Advanced-Analytics ist es, Unternehmen dabei zu helfen, datengestützte Entscheidungen zu treffen. Durch die Analyse von Daten können Unternehmen Trends vorhersagen, Risiken minimieren und Chancen maximieren. Es geht darum, einen Wettbewerbsvorteil zu erlangen, indem man Daten intelligent nutzt.

Ein weiteres Ziel von Advanced-Analytics ist es, Prozesse zu optimieren und Effizienzen zu steigern. Zum Beispiel kann ein Unternehmen durch die Analyse von Produktionsdaten Engpässe identifizieren und beseitigen. Im Marketing kann Advanced-Analytics helfen, gezieltere Kampagnen zu entwickeln und somit die Conversion-Raten zu erhöhen.

Darüber hinaus ermöglicht Advanced-Analytics eine personalisierte Kundenansprache. Durch die Analyse von Kundendaten können Unternehmen individuelle Angebote und Dienstleistungen entwickeln, die besser auf die Bedürfnisse ihrer Kunden abgestimmt sind.

Unterschied von Advanced-Analytics zu klassischen Analytics

Es gibt wesentliche Unterschiede zwischen Advanced-Analytics und klassischen Analytics:

- Klassische Analytics: Fokus auf die Analyse vergangener Daten und deskriptive Statistiken. Klassische Analytics beschränkt sich oft auf das Sammeln, Aufbereiten und Darstellen von Daten. Es handelt sich hauptsächlich um eine retrospektive Analyse, die beschreibt, was in der Vergangenheit passiert ist.

- Advanced-Analytics: Verwendung fortschrittlicher Techniken zur Vorhersage zukünftiger Ereignisse und Trends. Advanced-Analytics geht über die deskriptive Analyse hinaus und umfasst prädiktive und präskriptive Methoden. Diese Techniken ermöglichen es, zukünftige Entwicklungen vorherzusagen und konkrete Handlungsempfehlungen zu geben.

Ein weiterer Unterschied besteht in der Komplexität und den erforderlichen Fähigkeiten. Während klassische Analytics in der Regel grundlegende statistische Kenntnisse erfordert, benötigen Advanced-Analytics umfangreiche Kenntnisse in Statistik, Programmierung und maschinellem Lernen.

Unterschied von Advanced-Analytics zu Business Intelligence (BI)

Business Intelligence (BI) ist ein weiterer Begriff, der oft im Zusammenhang mit Datenanalyse verwendet wird. Die Unterschiede zu Advanced-Analytics sind:

- Business Intelligence (BI): Konzentriert sich auf das Sammeln und Analysieren von Daten, um historische Einblicke zu geben. BI-Systeme sind darauf ausgelegt, Daten aus verschiedenen Quellen zu integrieren und sie in verständlichen Berichten und Dashboards darzustellen. Sie helfen Unternehmen, ihre vergangene Leistung zu verstehen und operative Entscheidungen zu treffen.

- Advanced-Analytics: Geht einen Schritt weiter und schließt prädiktive und präskriptive Analysen ein. BI ist hauptsächlich beschreibend, während Advanced-Analytics vorhersagend und oft auch vorschreibend ist. Advanced-Analytics nutzt komplexere Algorithmen und Modelle, um zukünftige Entwicklungen vorherzusagen und strategische Entscheidungen zu unterstützen.

Ein weiterer Unterschied liegt in der Zielsetzung. Während BI darauf abzielt, Transparenz zu schaffen und operative Effizienzen zu steigern, zielt Advanced-Analytics darauf ab, Wettbewerbsvorteile zu erzielen und innovative Geschäftsmodelle zu entwickeln. Advanced-Analytics kann auch Echtzeit-Datenanalysen ermöglichen, was in schnelllebigen Branchen von entscheidender Bedeutung ist.

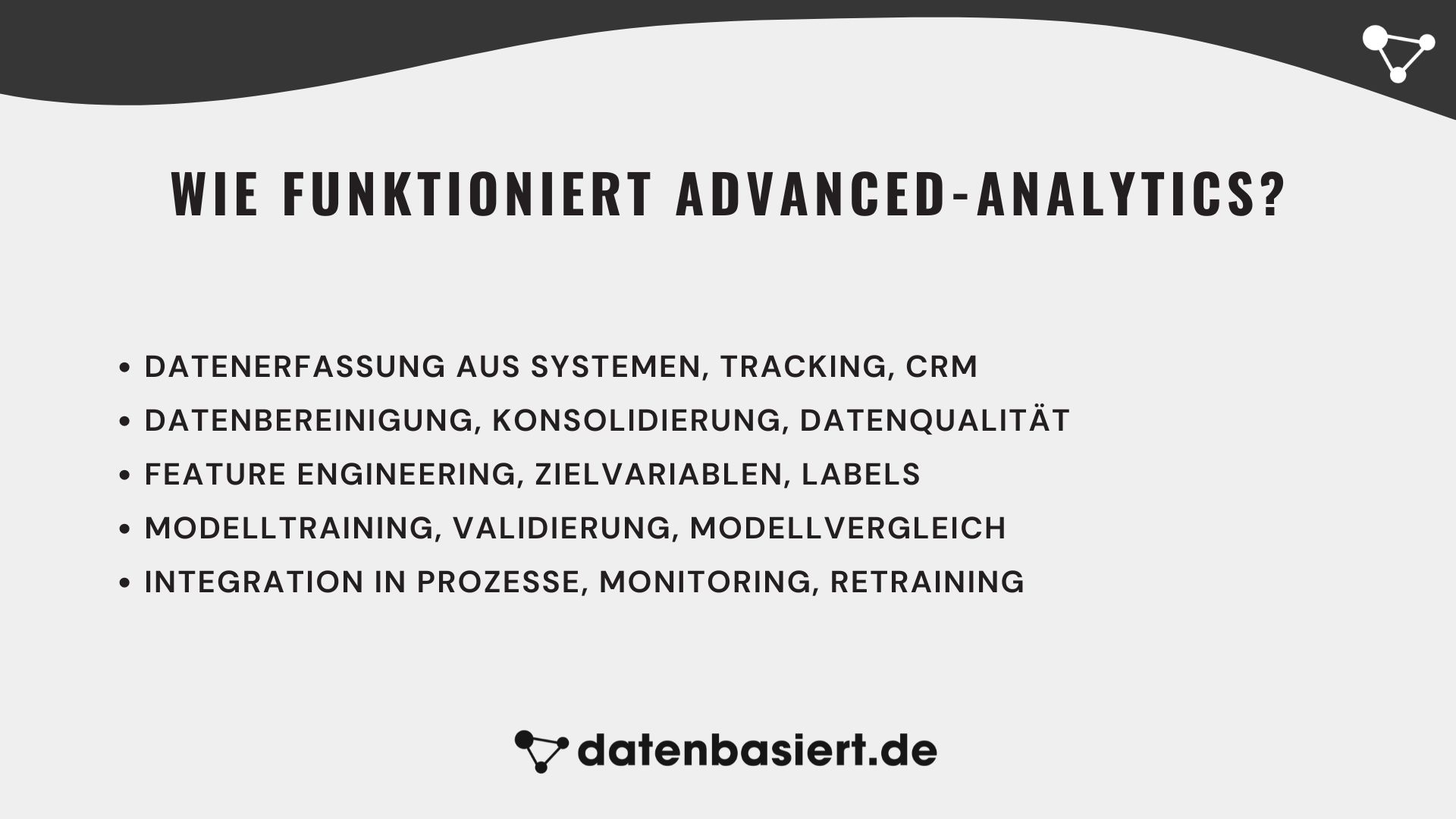

Wie funktioniert Advanced-Analytics?

Advanced Analytics basiert auf der Analyse großer Datenmengen und der Anwendung fortschrittlicher statistischer Techniken sowie Algorithmen des maschinellen Lernens. Der Prozess beginnt mit der Datenerfassung und -vorbereitung, gefolgt von der Modellentwicklung und endet mit der Implementierung der Ergebnisse in Geschäftsprozesse. Lassen Sie uns die einzelnen Schritte genauer betrachten.

Datenerfassung und -vorbereitung

Der erste Schritt im Advanced-Analytics-Prozess ist die Datenerfassung. Daten können aus verschiedenen Quellen stammen, einschließlich interner Datenbanken, externen Datenquellen, Sensoren, sozialen Medien und mehr. Diese Daten müssen gesammelt und in einem einheitlichen Format zusammengeführt werden.

Nach der Datenerfassung erfolgt die Datenbereinigung und -vorbereitung. Daten müssen auf Fehler überprüft und bereinigt werden. Fehlende Werte werden behandelt, doppelte Einträge entfernt und Inkonsistenzen korrigiert. Dieser Schritt ist entscheidend, da die Qualität der Daten direkt die Genauigkeit der Analyse beeinflusst.

Implementierung und Integration

Sobald das beste Modell ausgewählt ist, wird es in die Geschäftsprozesse integriert. Dies bedeutet, dass die Ergebnisse der Analyse genutzt werden, um Geschäftsentscheidungen zu treffen und Prozesse zu optimieren. Beispiele hierfür sind:

- Online-Marketing: Zielgerichtete Kampagnen basierend auf Kundensegmentierung und Verhalten.

- Finanzen: Risikomodelle zur Vorhersage von Kreditausfällen und zur Optimierung von Investitionen.

- Logistik: Optimierung der Lieferketten durch Vorhersage von Nachfrage und Bestandsmanagement.

Die Integration der Ergebnisse kann durch Dashboards, Berichte oder automatisierte Systeme erfolgen, die kontinuierlich Daten analysieren und aktualisieren. Diese Tools ermöglichen es, die gewonnenen Erkenntnisse in Echtzeit anzuwenden und flexibel auf Veränderungen zu reagieren.

Kontinuierliche Verbesserung

Advanced-Analytics ist kein einmaliger Prozess, sondern erfordert kontinuierliche Überwachung und Verbesserung. Die Modelle müssen regelmäßig aktualisiert und neu trainiert werden, um ihre Genauigkeit und Relevanz zu gewährleisten. Neue Datenquellen und Technologien können integriert werden, um die Analyse weiter zu verbessern.

Ein wichtiger Aspekt der kontinuierlichen Verbesserung ist die Feedback-Schleife. Die Ergebnisse und Erkenntnisse aus der Analyse sollten zurück in den Analyseprozess fließen, um die Modelle weiter zu verfeinern und zu verbessern. Dies stellt sicher, dass Advanced-Analytics immer auf dem neuesten Stand ist und die besten Ergebnisse liefert.

Advanced-Analytics bietet immense Möglichkeiten, aber es erfordert auch erhebliche Investitionen in Technologie, Datenmanagement und Fachwissen. Unternehmen, die diese Herausforderungen meistern, können jedoch erhebliche Wettbewerbsvorteile erzielen. Für weitere Einblicke in datengestützte Strategien, besuchen Sie unsere Artikel zur datengestützten Entscheidungsfindung und Marketing Automation.

Techniken und Methoden für Advanced-Analytics

Advanced-Analytics ist kein einzelnes Verfahren, sondern ein Werkzeugkasten aus verschiedenen Methoden, die je nach Fragestellung kombiniert werden. In der Praxis geht es meist darum, drei Dinge besser zu machen: zukünftiges Verhalten vorherzusagen, Zielgruppen und Muster zu verstehen und daraus konkrete Handlungsempfehlungen abzuleiten. Im Folgenden ein Überblick über zentrale Methoden, die in Advanced-Analytics-Projekten besonders häufig zum Einsatz kommen.

Predictive Analytics: Wahrscheinlichkeiten und Forecasts

Predictive Analytics ist der vielleicht bekannteste Baustein von Advanced Analytics. Ziel ist es, auf Basis historischer Daten die Wahrscheinlichkeit zukünftiger Ereignisse zu schätzen – etwa, ob ein Kunde kauft, abspringt oder auf eine Kampagne reagiert.

Typische Einsatzszenarien sind:

- Churn-Prognose: Welche Kunden haben eine hohe Abwanderungswahrscheinlichkeit, sodass sich Retention-Maßnahmen lohnen?

- Lead-Scoring: Welche Leads sind mit hoher Wahrscheinlichkeit kaufbereit und sollten vom Vertrieb priorisiert werden?

- Absatz- und Nachfrageprognosen: Wie entwickeln sich Bestellungen, Buchungen oder Website-Conversions in den nächsten Wochen?

Technisch kommen häufig Regressionsanalysen, Entscheidungsbäume, Gradient Boosting oder neuronale Netze zum Einsatz. In vielen Projekten reicht ein „einfacheres“ Modell, das stabil läuft und gut erklärbar ist, völlig aus – wichtig ist, dass die Prognosen zuverlässig genug sind, um Entscheidungen daran auszurichten.

Prescriptive Analytics: Was sollten wir tun?

Während Predictive Analytics beantwortet, was wahrscheinlich passieren wird, geht Prescriptive Analytics einen Schritt weiter und beantwortet, was wir tun sollten, um ein bestimmtes Ziel zu erreichen.

Typische Beispiele:

- Budget-Allokation: Wie verteilen wir ein fixes Marketingbudget optimal auf Kanäle, Kampagnen und Zielgruppen?

- Dynamic Pricing: Welche Preise maximieren Marge oder Auslastung, ohne die Nachfrage zu stark zu drücken?

- Next-Best-Action: Welche Aktion (Rabatt, Cross-Sell, Reminder, nichts tun) ist für einen bestimmten Kunden aktuell die beste Option?

Dafür werden Vorhersagemodelle oft mit Optimierungs- und Simulationsverfahren kombiniert. Neben den Daten spielen hier Geschäftsregeln eine große Rolle (z. B. Budgetgrenzen, rechtliche Vorgaben, Brand-Guidelines), die in das Modell integriert werden müssen.

Kohortenanalyse: Verhalten über die Zeit verstehen

Kohortenanalysen gruppieren Nutzer oder Kunden in Kohorten, die ein gemeinsames Start-Ereignis teilen – etwa den ersten Kauf, die Registrierung oder die erste Kampagnenreaktion. Anschließend wird das Verhalten dieser Kohorten über die Zeit miteinander verglichen.

Das ist besonders nützlich, um Fragen wie diese zu beantworten:

- Bleiben Kunden aus bestimmten Akquisekanälen länger aktiv oder kommen häufiger zurück?

- Hat eine Produktänderung oder Preisanpassung die langfristige Kundenbindung verbessert oder verschlechtert?

- Wie entwickeln sich Retention, Umsatz pro Kunde oder Customer Lifetime Value über verschiedene Kohorten hinweg?

Im Kontext von Advanced-Analytics wird die Kohortenlogik häufig mit Predictive-Modellen kombiniert, um z. B. zukünftige Umsätze einer Kohorte zu prognostizieren oder für einzelne Kohorten unterschiedliche Maßnahmen abzuleiten.

Clustering: Muster und Segmente ohne Label

Clustering gehört zu den unüberwachten Lernverfahren (Unsupervised Learning). Das Ziel: Datenpunkte – etwa Kunden, Produkte oder Sessions – auf Basis ihrer Ähnlichkeit in Gruppen zu clustern, ohne dass vorher Labels vorgegeben werden.

Typische Anwendungsfälle:

- Kundensegmente: Bildung von Verhaltens- oder Wertsegmenten, die für Targeting, Personalisierung oder Produktentwicklung genutzt werden.

- Produktsortierung: Gruppierung ähnlicher Produkte für bessere Navigation, Filterlogik oder Bundles.

- Anomalieerkennung: Identifikation von „Ausreißern“, z. B. ungewöhnlichen Bestellmustern oder verdächtigen Transaktionen.

Technisch kommen u. a. k-Means, hierarchische Clusterverfahren oder dichtebasierte Methoden wie DBSCAN zum Einsatz. Wichtig ist weniger der „perfekte“ Algorithmus als eine sinnvolle Feature-Auswahl und eine saubere Interpretation der gefundenen Cluster in der Business-Logik.

Empfehlungsalgorithmen: Next Best Product & Content

Empfehlungsalgorithmen (Recommender-Systeme) sind in vielen B2C-Szenarien ein zentraler Advanced-Analytics-Baustein – vom E-Commerce über Medienplattformen bis hin zu B2B-Produktkatalogen.

Grob lassen sich drei Ansätze unterscheiden:

- Regelbasierte Empfehlungen: Einfache Heuristiken wie „Bestseller“, „ähnliche Produkte“ oder „Kunden kauften auch“. Schnell umsetzbar, aber begrenzt personalisiert.

- Collaborative Filtering: Empfehlungen auf Basis des Verhaltens ähnlicher Nutzer („Nutzer mit ähnlichem Kaufverhalten wie du fanden X spannend“).

- Content-basierte Empfehlungen: Empfehlungen basierend auf Eigenschaften von Produkten oder Inhalten (Kategorie, Preis, Merkmale, Text etc.).

In der Praxis werden diese Ansätze häufig hybrid eingesetzt und mit Predictive-Scorings (z. B. Kaufwahrscheinlichkeit für ein bestimmtes Produkt) kombiniert. So entstehen Recommendation-Engines, die in Echtzeit personalisierte Vorschläge über Website, App, E-Mail oder CRM-Kanäle ausspielen.

Methoden kombinieren statt isoliert denken

Die größte Hebelwirkung entsteht selten durch eine einzelne Methode, sondern durch klug kombinierte Bausteine. Ein typisches Setup könnte z. B. so aussehen:

- Kohortenanalyse und Clustering, um Zielgruppen und Verhaltensmuster zu verstehen,

- Predictive-Analytics, um für diese Segmente Wahrscheinlichkeiten und Forecasts zu berechnen,

- Prescriptive-Analytics und Empfehlungsalgorithmen, um daraus konkrete Aktionen abzuleiten – etwa Budgets, Angebote oder Inhalte.

Advanced-Analytics wird damit zu einem geschlossenen Kreislauf: Daten werden gesammelt, in Muster übersetzt, in Vorhersagen transformiert und schließlich in konkrete Entscheidungen und Maßnahmen überführt, die wiederum neue Daten liefern.

Welche Vorteile bietet Advanced-Analytics?

Advanced-Analytics bietet eine Vielzahl von Vorteilen, die Unternehmen dabei helfen, ihre Geschäftsstrategien zu optimieren und fundierte Entscheidungen zu treffen. Durch die Nutzung fortschrittlicher Analysetechniken können Unternehmen tiefere Einblicke in ihre Daten gewinnen und dadurch Wettbewerbsvorteile erzielen. In diesem Abschnitt werden wir die wichtigsten Vorteile von Advanced-Analytics detailliert erläutern.

Verbesserte Entscheidungsfindung

Einer der größten Vorteile von Advanced-Analytics ist die verbesserte Entscheidungsfindung. Durch die Analyse großer Datenmengen können Unternehmen fundierte und datengetriebene Entscheidungen treffen. Anstatt sich auf Bauchgefühl oder unvollständige Informationen zu verlassen, können Entscheidungsträger auf präzise und aktuelle Daten zugreifen.

- Reduzierung von Risiken: Advanced-Analytics ermöglicht es Unternehmen, potenzielle Risiken frühzeitig zu erkennen und geeignete Maßnahmen zu ergreifen. Zum Beispiel können Finanzinstitute Kreditrisiken besser bewerten und so das Risiko von Zahlungsausfällen minimieren.

- Optimierung von Geschäftsstrategien: Durch die Analyse von Marktdaten und Kundenverhalten können Unternehmen ihre Strategien kontinuierlich anpassen und optimieren. Dies führt zu einer besseren Marktausrichtung und höheren Erfolgsquoten.

Effizienzsteigerung

Ein weiterer wesentlicher Vorteil von Advanced-Analytics ist die Steigerung der Effizienz in verschiedenen Geschäftsprozessen. Durch die Identifizierung von Engpässen und Ineffizienzen können Unternehmen ihre Abläufe optimieren und Ressourcen besser nutzen.

- Prozessoptimierung: In der Produktion können Unternehmen durch die Analyse von Maschinendaten Wartungsintervalle optimieren und Ausfallzeiten reduzieren. Dies führt zu einer höheren Produktionsauslastung und Kosteneinsparungen.

- Supply Chain Management: Advanced-Analytics kann helfen, Lieferketten zu optimieren, indem es Vorhersagen über die Nachfrage und den Lagerbestand trifft. Dadurch können Bestände reduziert und die Lieferzeiten verkürzt werden.

Personalisierte Kundenerfahrungen

Advanced-Analytics ermöglicht es Unternehmen, ihre Kunden besser zu verstehen und personalisierte Erlebnisse zu schaffen. Durch die Analyse von Kundenverhalten und -präferenzen können maßgeschneiderte Angebote und Empfehlungen entwickelt werden.

- Zielgerichtetes Marketing: Durch die Segmentierung von Kunden und die Analyse ihres Verhaltens können Unternehmen gezielte Marketingkampagnen entwickeln, die eine höhere Conversion-Rate und Kundenbindung erzielen.

- Verbesserter Kundenservice: Mit Advanced-Analytics können Unternehmen häufige Kundenanfragen und Probleme identifizieren und proaktive Lösungen anbieten. Dies verbessert die Kundenzufriedenheit und reduziert die Anzahl der Beschwerden.

Wettbewerbsvorteile

Durch den Einsatz von Advanced-Analytics können Unternehmen signifikante Wettbewerbsvorteile erzielen. Sie können Markttrends schneller erkennen und darauf reagieren, was ihnen einen Vorsprung vor ihren Mitbewerbern verschafft.

- Innovationsförderung: Advanced-Analytics kann Unternehmen dabei helfen, innovative Produkte und Dienstleistungen zu entwickeln, indem sie Marktlücken und neue Trends identifizieren. Dies unterstützt die kontinuierliche Weiterentwicklung und Differenzierung vom Wettbewerb.

- Schnellere Reaktionszeiten: Mit der Fähigkeit, Echtzeitdaten zu analysieren, können Unternehmen schneller auf Marktveränderungen reagieren und ihre Strategien anpassen. Dies ist besonders in schnelllebigen Branchen wie Technologie und Einzelhandel von Vorteil.

Kosteneinsparungen

Advanced-Analytics trägt auch zur Reduzierung von Kosten bei, indem es ineffiziente Prozesse identifiziert und optimiert. Durch die Automatisierung von Analyseprozessen und die Nutzung von Predictive Analytics können Unternehmen ihre Ausgaben effizienter gestalten.

- Reduzierung von Betriebskosten: Durch die Analyse von Betriebsdaten können Unternehmen ineffiziente Prozesse identifizieren und optimieren, was zu erheblichen Kosteneinsparungen führt.

- Effiziente Ressourcennutzung: Advanced-Analytics hilft Unternehmen, ihre Ressourcen besser zu planen und zu nutzen, was ebenfalls zur Senkung der Betriebskosten beiträgt.

Anwendungsfälle und Beispiele für Advanced-Analytics

Advanced-Analytics findet in einer Vielzahl von Bereichen, wo es dazu beiträgt, komplexe Probleme zu lösen, Prozesse zu optimieren und fundierte Entscheidungen zu unterstützen. Im Folgenden werden einige der Anwendungsfälle von Advanced-Analytics näher erläutert.

Marketing

Advanced-Analytics und K.I. revolutioniert das Marketing, indem es Unternehmen ermöglicht, ihre Marketingstrategien zu verfeinern, Zielgruppen besser zu verstehen und die Effektivität ihrer Kampagnen zu maximieren.

- Attributionsanalyse: Zuordnung von Verkaufserlösen und Conversions zu verschiedenen Marketingkanälen, um die ROI einzelner Kanäle zu bewerten.

- Personalisierung des Inhalts: Nutzung von Datenanalysen zur Erstellung personalisierter Inhalte, die auf die spezifischen Bedürfnisse und Präferenzen der Zielgruppe zugeschnitten sind.

- Segmentierung und Targeting: Segmentierung der Zielgruppe basierend auf demografischen Merkmalen, Verhaltensdaten und Interessen, um gezielte Marketingkampagnen durchzuführen.

- Optimierung der Conversion-Rate: Analyse von Website-Daten, um Schwachstellen im Conversion-Funnel zu identifizieren und zu optimieren.

- Social Media Analytics: Auswertung von Social Media-Daten, um die Performance von Kampagnen zu überwachen, das Engagement zu erhöhen und Trends frühzeitig zu erkennen.

- Customer Journey-Analyse: Verfolgung und Analyse der gesamten Customer Journey, um Touchpoints zu identifizieren, die entscheidend für den Kaufprozess sind.

- ROI-Analyse für Kampagnen: Berechnung des Return on Investment für Marketingkampagnen, um die Effizienz und Rentabilität der Investitionen zu bewerten.

- Predictive Lead Scoring: Einsatz von Datenanalysen zur Vorhersage von potenziell qualifizierten Leads und zur Priorisierung von Vertriebsaktivitäten.

- Geo-Targeting und Geo-Fencing: Nutzung von geografischen Daten zur Auslieferung gezielter Werbebotschaften und zur Steigerung der lokalen Präsenz.

- A/B-Tests und Multivariate Tests: Experimente zur Optimierung von Kampagnen und Webseiten durch Vergleich unterschiedlicher Varianten, um die beste Leistung zu erzielen.

Vertrieb und CRM

Advanced-Analytics spielt eine entscheidende Rolle im Vertrieb und Customer Relationship Management (CRM), indem es Unternehmen hilft, ihre Verkaufsprozesse zu optimieren, Kundenbeziehungen zu stärken und Umsatzpotenziale besser auszuschöpfen.

- Forecasting und Umsatzprognosen: Nutzung von Datenanalysen zur Vorhersage von Verkaufstrends und zur Optimierung der Vertriebsstrategien.

- Kundenanalyse und -segmentierung: Identifikation wertvoller Kundenprofile und Segmentierung basierend auf demografischen Merkmalen, Kaufverhalten und Kundenbedürfnissen.

- Churn-Prädiktion: Analyse von Kundenverhaltensdaten zur frühzeitigen Erkennung von Abwanderungstendenzen und zur Implementierung geeigneter Maßnahmen zur Kundenbindung.

- Vertriebsleistungsoptimierung: Bewertung der Effektivität von Vertriebsaktivitäten und Identifikation von Verbesserungspotenzialen durch Performance-Analysen.

- Upselling und Cross-Selling: Nutzung von Datenanalysen, um gezielte Upselling- und Cross-Selling-Strategien zu entwickeln und die Kundenbindung zu erhöhen.

- Vertriebskanalanalyse: Bewertung der Performance verschiedener Vertriebskanäle und Identifikation der rentabelsten Kanäle zur Optimierung der Ressourcennutzung.

- Kundenfeedback-Analyse: Auswertung von Kundenrückmeldungen und Interaktionen, um die Servicequalität zu verbessern und Kundenbedürfnisse besser zu verstehen.

- Vertriebsprognosen und Zielsetzung: Nutzung von Predictive Analytics, um realistische Verkaufsziele zu setzen und die Vertriebsressourcen effizient zu planen.

- Automatisierung von Vertriebsprozessen: Einsatz von Analysetools zur Automatisierung von Vertriebsprozessen, um die Effizienz zu steigern und die Reaktionszeiten zu verkürzen.

- Personalisierung im Verkaufsprozess: Anpassung von Verkaufsstrategien und Kundeninteraktionen basierend auf individuellen Kundenpräferenzen und Verhaltensmustern.

Entscheidungsfindung

Advanced-Analytics spielt eine entscheidende Rolle bei der Unterstützung von Entscheidungsträgern in Unternehmen, indem es komplexe Daten analysiert und fundierte Entscheidungen ermöglicht.

- Datengetriebene Entscheidungsfindung: Nutzung von Datenanalysen zur Unterstützung strategischer und operativer Entscheidungen.

- Risikoanalyse und -management: Identifikation und Bewertung potenzieller Risiken durch Analyse großer Datenmengen.

- Szenarioanalyse: Modellierung verschiedener Szenarien basierend auf historischen Daten und aktuellen Marktbedingungen.

- Optimierung von Geschäftsprozessen: Analyse von Prozessdaten zur Identifizierung von Engpässen und Effizienzsteigerungen.

- ROI-Analyse: Berechnung des Return on Investment für geplante Projekte und Investitionen.

- Markttrendanalyse: Früherkennung von Markttrends und Ableitung strategischer Maßnahmen.

- Customer Lifetime Value-Analyse: Bewertung des langfristigen Kundenwerts zur Optimierung von Marketing- und Vertriebsstrategien.

- Technologieevaluierung: Vergleich und Bewertung neuer Technologien und Tools für die Unternehmensanwendung.

- Performance-Monitoring: Kontinuierliche Überwachung der Leistungskennzahlen zur rechtzeitigen Anpassung von Geschäftsstrategien.

- Echtzeit-Entscheidungsunterstützung: Nutzung von Echtzeitdaten zur schnellen Entscheidungsfindung in dynamischen Geschäftsumgebungen.

Beratung

In der Beratungsbranche unterstützt Advanced-Analytics Berater dabei, fundierte Empfehlungen zu geben und Geschäftsprozesse ihrer Kunden zu optimieren.

- Datengetriebene Entscheidungsfindung: Analyse von Geschäftsdaten zur Identifizierung von Optimierungspotenzialen und zur Entwicklung strategischer Empfehlungen.

- Performance-Analyse: Bewertung der Effektivität von Geschäftsstrategien und Maßnahmen durch datengestützte Performance-Analysen.

- Kosten-Nutzen-Analyse: Einsatz von Datenanalysen zur Bewertung von Investitionen und zur Ableitung von ROI (Return on Investment)-Kennzahlen.

Finanzwesen und Risikomanagement

Im Finanzsektor wird Advanced-Analytics intensiv genutzt, um Risiken zu bewerten, Betrug zu erkennen und Finanzprognosen zu erstellen. Banken und Finanzinstitutionen verwenden Modelle wie Kreditrisikobewertung, Betrugsanalyse und Portfoliooptimierung, um ihre finanzielle Gesundheit zu verbessern und optimale Entscheidungen zu treffen.

- Kreditrisikobewertung: Analyse von Kreditnehmerdaten zur Vorhersage von Zahlungsausfällen und Risikobewertung.

- Betrugsanalyse: Identifikation verdächtiger Transaktionen und Muster, um finanziellen Schaden zu minimieren.

- Portfoliooptimierung: Nutzung von Analysemodellen zur Auswahl und Verwaltung von Investitionen.

Gesundheitswesen und Medizin

Im Gesundheitswesen unterstützt Advanced-Analytics die klinische Entscheidungsfindung, verbessert die Patientenversorgung und ermöglicht präventive Maßnahmen durch die Analyse von Patientendaten, medizinischen Bildern und Behandlungsverläufen.

- Klinische Entscheidungsunterstützung: Analyse von Patientendaten zur Diagnosestellung und Behandlungsempfehlungen.

- Präventive Gesundheitsmaßnahmen: Früherkennung von Krankheiten durch die Analyse von Gesundheitsdaten und Risikofaktoren.

- Medikamentenentwicklung: Verwendung von Datenanalysen, um den Entwicklungsprozess neuer Medikamente zu beschleunigen.

Produktion und Logistik

In der Produktion und Logistik hilft Advanced-Analytics bei der Optimierung von Fertigungsprozessen, der Bestandsverwaltung und der Lieferkettenplanung, um Effizienzsteigerungen und Kostenreduktionen zu erreichen.

- Fertigungsprozessoptimierung: Analyse von Produktionsdaten zur Identifizierung von Engpässen und Effizienzsteigerungen.

- Bestandsmanagement: Vorhersage der Nachfrage und Optimierung der Lagerbestände zur Minimierung von Überbeständen und Engpässen.

- Lieferkettenplanung: Nutzung von Datenanalysen zur Verbesserung der Lieferzeiten und zur Sicherstellung der Produktverfügbarkeit.

Advanced-Analytics bietet Unternehmen in verschiedenen Branchen die Möglichkeit, ihre operativen Prozesse zu optimieren, fundierte Entscheidungen zu treffen und Wettbewerbsvorteile zu erzielen. Erfahren Sie mehr über spezifische Anwendungen und Fallstudien in unserem Artikel über Predictive Analytics und Prescriptive Analytics.

Tools für Advanced-Analytics

Advanced-Analytics erfordert spezialisierte Tools und Plattformen, die Unternehmen dabei unterstützen, große Datenmengen zu analysieren, komplexe Modelle zu erstellen und fundierte Erkenntnisse zu gewinnen. Hier sind einige der führenden Advanced-Analytics-Tools und Technologien, die für Advanced-Analytics verwendet werden:

1. Data Mining Tools

Data Mining Tools wie IBM SPSS Modeler, RapidMiner und Knime ermöglichen es Analysten, Muster und Zusammenhänge in großen Datensätzen zu identifizieren und zu extrahieren.

- IBM SPSS Modeler: IBM SPSS Modeler ist eine umfassende Predictive Analytics Software, die für die Erstellung und Ausführung von Vorhersagemodellen verwendet wird. Es bietet eine grafische Benutzeroberfläche zur Datenexploration, Modellentwicklung und -bewertung.

- RapidMiner: RapidMiner ist eine Open-Source-Plattform für Data Science, die eine visuelle Programmierungsumgebung für das Data Mining und die maschinelle Lernmodellierung bietet. Es wird häufig für die Analyse von Kundenverhalten, Churn-Prädiktion und Marktsegmentierung eingesetzt.

- Knime: Knime ist eine Open-Source-Plattform für die Datenanalyse und Integration. Es unterstützt die visuelle Erstellung von Datenpipelines zur Datenverarbeitung, Modellierung und Berichterstellung in verschiedenen Branchen wie Gesundheitswesen, Finanzwesen und E-Commerce.

- Weka: Weka ist eine beliebte Open-Source-Software für maschinelles Lernen und Data Mining. Es bietet eine Sammlung von Algorithmen für die Datenanalyse und -modellierung sowie Tools für die Datenpräparation, -visualisierung und -bewertung.

- Orange: Orange ist eine Open-Source-Plattform für maschinelles Lernen und Datenvisualisierung, die eine visuelle Programmiersprache für die Datenanalyse und -modellierung bietet. Es wird für die explorative Datenanalyse, Vorhersagemodelle und Clusteranalysen verwendet.

2. Business Intelligence Plattformen

Business Intelligence (BI) Plattformen wie Tableau, Power BI und Qlik bieten Funktionen zur Datenvisualisierung und -analyse, die für das Reporting und die Entscheidungsunterstützung entscheidend sind.

- Tableau: Tableau ist eine führende BI-Plattform, die interaktive Datenvisualisierungen und Business-Dashboards ermöglicht. Es wird verwendet, um komplexe Daten in aussagekräftige Einblicke umzuwandeln und Berichte in Echtzeit zu erstellen.

- Power BI: Power BI ist eine cloudbasierte Business Analytics-Lösung von Microsoft, die Datenvisualisierung, Self-Service-Business Intelligence und Zusammenarbeit in einem einzigen Tool vereint. Es wird für die Erstellung interaktiver Berichte, Dashboards und zur Datenanalyse in Unternehmen jeder Größe verwendet.

- Qlik: Qlik ist eine Analytics-Plattform, die assoziative Datenindexierung und patentierte Technologien für die Datenvisualisierung und -analyse nutzt. Es ermöglicht Benutzern, Datenbeziehungen zu erkunden, um verborgene Erkenntnisse aufzudecken und datengesteuerte Entscheidungen zu treffen.

- Looker: Looker ist eine Datenplattform, die Unternehmen hilft, ihre Daten zu explorieren und zu nutzen. Es bietet Funktionen für die Datenanalyse, Visualisierung und Zusammenarbeit, die Unternehmen helfen, datengesteuerte Entscheidungen zu treffen.

- Sisense: Sisense ist eine Plattform für Business Intelligence und Analytik, die eine umfassende Lösung für die Datenvisualisierung, Berichterstellung und Analyse bietet. Es wird für die Integration und Analyse von Daten aus verschiedenen Quellen verwendet, um Geschäftsergebnisse zu optimieren.

3. Predictive Analytics Software

Tools zur Vorhersageanalyse wie SAS Predictive Analytics, Python mit Scikit-Learn und R mit caret ermöglichen es Unternehmen, zukünftige Ereignisse und Trends basierend auf historischen Daten zu prognostizieren.

- SAS Predictive Analytics: SAS Predictive Analytics ist eine umfassende Plattform für die statistische Analyse und Modellierung, die zur Entwicklung und Implementierung von prädiktiven Modellen in verschiedenen Branchen eingesetzt wird. Es bietet fortschrittliche Analysetechniken zur Vorhersage von Ereignissen und zur Optimierung von Entscheidungen.

- Python mit Scikit-Learn: Scikit-Learn ist eine Open-Source-Bibliothek für maschinelles Lernen in Python. Es bietet Algorithmen für die Datenanalyse und -modellierung, einschließlich Klassifizierung, Regressionsanalysen, Clustering und Dimensionalitätsreduktion.

- R mit caret: caret (Classification And REgression Training) ist eine R-Bibliothek für maschinelles Lernen und Data Mining. Es bietet Tools zur Modellierung und Evaluierung von Klassifikations- und Regressionsmodellen unter Verwendung verschiedener Algorithmen.

- IBM Watson Studio: IBM Watson Studio ist eine integrierte Umgebung für Datenwissenschaft, maschinelles Lernen und KI. Es bietet Werkzeuge zur Datenexploration, Modellentwicklung und -bereitstellung für prädiktive Analyseprojekte.

- Alteryx: Alteryx ist eine Plattform für Datenpräparation und -analyse, die Werkzeuge zur Datenintegration, Vorhersagemodellierung und Berichterstellung bietet. Es wird verwendet, um komplexe Datenpipelines zu erstellen und datengetriebene Entscheidungen zu unterstützen.

4. Machine Learning Frameworks

Frameworks für maschinelles Lernen wie TensorFlow, PyTorch und Scikit-Learn bieten umfassende Möglichkeiten zur Entwicklung und Implementierung von Machine Learning Modellen für komplexe Analyseaufgaben.

- TensorFlow: TensorFlow ist ein Open-Source-Framework für maschinelles Lernen und Deep Learning, das von Google entwickelt wurde. Es bietet umfangreiche Funktionen für die Erstellung und Bereitstellung von neuronalen Netzwerken und anderen maschinellen Lernalgorithmen.

- PyTorch: PyTorch ist ein Open-Source-Deep-Learning-Framework, das Flexibilität und schnelle Iterationen in der Modellentwicklung bietet. Es wird für die Forschung, Prototyping und Produktion in Bereichen wie Bilderkennung, natürliche Sprachverarbeitung und KI verwendet.

- Scikit-Learn: Scikit-Learn ist eine Python-Bibliothek für maschinelles Lernen, die einfache und effiziente Werkzeuge für Datenanalyse und maschinelles Lernen bietet. Es enthält Algorithmen für Klassifizierung, Regression, Clustering und Dimensionalitätsreduktion.

- Keras: Keras ist eine Open-Source-Neural-Network-Bibliothek, die auf TensorFlow, Theano oder CNTK aufbaut. Es bietet eine benutzerfreundliche API für die schnelle Entwicklung und Prototypisierung von Deep-Learning-Modellen.

- MXNet: Apache MXNet ist ein schnelles und skalierbares Framework für Deep Learning, das sowohl für akademische Forschung als auch für industrielle Anwendungen geeignet ist. Es unterstützt mehrere Programmiersprachen einschließlich Python, Scala und R.

5. Big Data Plattformen

Big Data Plattformen wie Apache Hadoop und Apache Spark unterstützen die Verarbeitung und Analyse großer Datenmengen in verteilten Systemen, um Skalierbarkeit und Leistung zu gewährleisten.

- Apache Hadoop: Apache Hadoop ist ein Open-Source-Framework für die verteilte Speicherung und Verarbeitung großer Datenmengen über Cluster von Computern. Es umfasst Hadoop Distributed File System (HDFS) und MapReduce zur parallelen Datenverarbeitung.

- Apache Spark: Apache Spark ist ein leistungsstarkes Open-Source-Cluster-Computing-Framework für Big Data. Es bietet APIs für Scala, Java, Python und R sowie Bibliotheken für SQL, Streaming-Datenverarbeitung und maschinelles Lernen.

- HBase: Apache HBase ist eine verteilte, spaltenorientierte NoSQL-Datenbank, die auf Hadoop aufbaut. Es wird verwendet, um schnellen und zufälligen Zugriff auf große Datenmengen zu ermöglichen, die in Hadoop HDFS gespeichert sind.

- Cassandra: Apache Cassandra ist eine Open-Source-NoSQL-Datenbank, die für die Verwaltung großer Mengen strukturierter und semi-strukturierter Daten über mehrere Rechenzentren hinweg optimiert ist. Es bietet hohe Verfügbarkeit und Skalierbarkeit.

- Databricks: Databricks ist eine Unified-Analytics-Plattform, die auf Apache Spark basiert und Funktionen für Datenengineering, maschinelles Lernen und kollaborative Datenanalyse bietet. Es wird häufig für die Analyse großer Datenmengen in der Cloud verwendet.

6. Text Mining und Natural Language Processing (NLP) Tools

Tools für Text Mining und NLP wie NLTK (Natural Language Toolkit), spaCy und TextBlob ermöglichen die Analyse und Verarbeitung von Textdaten zur Extraktion von Informationen und Erkenntnissen.

- NLTK (Natural Language Toolkit): NLTK ist eine führende Plattform für die Verarbeitung von natürlicher Sprache in Python. Es bietet Werkzeuge und Ressourcen für die Tokenisierung, Stemming, Lemmatisierung, Markierung und syntaktische Analyse von Text.

- spaCy: spaCy ist eine Open-Source-Bibliothek für die fortschrittliche natürliche Sprachverarbeitung in Python. Es bietet vortrainierte Modelle für Named Entity Recognition (NER), Part-of-Speech Tagging (POS) und Textklassifizierung.

- TextBlob: TextBlob ist eine einfach zu verwendende Python-Bibliothek für die Textverarbeitung und -analyse. Es bietet Funktionen zur Erkennung der Sprache, Übersetzung, Sentimentanalyse und Klassifizierung von Text.

- Gensim: Gensim ist eine Python-Bibliothek für die Themenmodellierung und semantische Analyse von Text. Es bietet Implementierungen von Algorithmen wie Latent Semantic Analysis (LSA) und Latent Dirichlet Allocation (LDA).

- Stanford NLP: Stanford NLP ist eine Sammlung von natürlichsprachlichen Verarbeitungstools, die von der Stanford University entwickelt wurden. Es bietet leistungsstarke Werkzeuge für die Tokenisierung, Part-of-Speech Tagging, Syntaxanalyse und Entitätsauflösung.

7. Cloud-basierte Analytics Plattformen

Cloud-basierte Analytics Plattformen bieten skalierbare Infrastrukturen und Dienste für die Datenverarbeitung und Analyse in der Cloud-Umgebung.

- Google BigQuery: Google BigQuery ist ein vollständig verwalteter, serverloser Data Warehouse-Dienst von Google Cloud. Es bietet schnelle SQL-Abfragen und Unterstützung für die Analyse großer Datenmengen in Echtzeit.

- Amazon Redshift: Amazon Redshift ist ein vollständig verwaltetes Data Warehouse von AWS, das für die Analyse großer Datensätze mit SQL-Abfragen optimiert ist. Es bietet Skalierbarkeit, hohe Leistung und Integration mit anderen AWS-Diensten.

- Snowflake: Snowflake ist eine Cloud-basierte Data-Warehouse-Plattform, die eine skalierbare, elastische Architektur für die Verarbeitung und Analyse strukturierter und halbstrukturierter Daten bietet. Es unterstützt verschiedene Workloads und Datenintegrationen.

- Microsoft Azure Synapse Analytics: Azure Synapse Analytics (früher SQL Data Warehouse) ist ein Cloud-basiertes Data Warehouse von Microsoft Azure. Es ermöglicht die Integration von Big Data und Echtzeit-Analytik in einer einzigen Plattform.

- Databricks: Databricks ist eine Unified-Analytics-Plattform, die auf Apache Spark basiert und Funktionen für Datenengineering, maschinelles Lernen und kollaborative Datenanalyse bietet. Es wird häufig für die Analyse großer Datenmengen in der Cloud verwendet.

8. Geospatial Analytics Tools

Geospatial Analytics Tools ermöglichen die Analyse von räumlichen und geografischen Daten zur Erkennung von Mustern, Trends und Standortbezügen.

- Esri ArcGIS: Esri ArcGIS ist eine Plattform für Geoinformationssysteme (GIS), die Werkzeuge für die Erfassung, Verwaltung, Analyse und Darstellung von geografischen Daten bietet. Es wird in Branchen wie Stadtplanung, Umweltmanagement und Telekommunikation eingesetzt.

- QGIS: QGIS (Quantum GIS) ist eine Open-Source-Software für Geoinformationssysteme, die umfangreiche Funktionen für die Analyse und Visualisierung räumlicher Daten bietet. Es wird von Regierungen, Forschungseinrichtungen und Unternehmen weltweit verwendet.

- MapInfo Pro: MapInfo Pro ist eine Desktop-Anwendung für Geografische Informationssysteme (GIS), die für die Erstellung, Bearbeitung und Analyse räumlicher Daten verwendet wird. Es bietet Werkzeuge für Standortanalyse, Kartenerstellung und Datenvisualisierung.

- Google Earth Engine: Google Earth Engine ist eine Plattform für die Analyse von räumlichen und Zeitreihendaten aus Satellitenbildern. Es wird für Umweltüberwachung, Landnutzung, Klimamodellierung und Naturkatastrophenmanagement verwendet.

- CARTO: CARTO ist eine Plattform für Location Intelligence und räumliche Analyse, die Werkzeuge für die Erstellung interaktiver Karten, Datenvisualisierung und Standortanalyse bietet. Es unterstützt die Nutzung von Geodaten für geschäftliche Entscheidungen.

9. Streaming Analytics Plattformen

Streaming Analytics Plattformen ermöglichen die Echtzeitverarbeitung und Analyse von Datenströmen zur sofortigen Erkennung von Ereignissen und Muster.

- Apache Kafka: Apache Kafka ist eine verteilte Streaming-Plattform, die für die Verarbeitung von Datenströmen in Echtzeit verwendet wird. Es unterstützt die Hochverfügbarkeit und Skalierbarkeit von Datenströmen in großen verteilten Systemen.

- Spark Streaming: Spark Streaming ist eine Erweiterung von Apache Spark für die Verarbeitung von Echtzeitdatenströmen. Es ermöglicht die Integration von Batch- und Streaming-Datenverarbeitung innerhalb einer einzigen Plattform.

- Amazon Kinesis: Amazon Kinesis ist ein verwalteter Service von AWS für die Verarbeitung von Echtzeit-Datenströmen. Es bietet APIs für die Datenaufnahme, Verarbeitung und Analyse in Echtzeit mit hoher Zuverlässigkeit und Skalierbarkeit.

- StreamSets: StreamSets ist eine Plattform für die Datenstromverarbeitung, die Design, Betrieb und Überwachung von Datenpipelines vereinfacht. Es unterstützt die Echtzeitverarbeitung von Datenströmen aus verschiedenen Quellen und Zielen.

- Flink: Apache Flink ist ein verteiltes Streaming-Framework für die Echtzeitverarbeitung von Datenströmen. Es bietet fortschrittliche Funktionen wie Zustandsverwaltung, Eventzeitverarbeitung und maschinelles Lernen in Echtzeit.

Wie implementiert man Advanced-Analytics in einem Unternehmen?

Die Implementierung von Advanced-Analytics in einem Unternehmen erfordert eine strukturierte Vorgehensweise, um sicherzustellen, dass die Analyse von Daten effektiv genutzt wird, um Geschäftswert zu schaffen. Hier sind die Schritte zur erfolgreichen Implementierung:

1. Strategische Planung und Zielsetzung

Beginnen Sie mit einer klaren Definition der Ziele und strategischen Prioritäten, die durch Advanced-Analytics unterstützt werden sollen. Identifizieren Sie die geschäftlichen Herausforderungen oder Chancen, die durch Datenanalyse adressiert werden sollen.

- Definieren Sie klare Ziele, die messbar und auf die Geschäftsstrategie ausgerichtet sind, z.B. die Verbesserung der Kundenbindung, die Optimierung von Betriebsabläufen oder die Steigerung der Umsatzrentabilität.

- Erstellen Sie einen Fahrplan für die Implementierung von Advanced-Analytics, der Phasen, Zeitrahmen und Ressourcenallokationen umfasst.

- Schaffen Sie eine Datenkultur und fördern Sie das Verständnis für die Bedeutung datengestützter Entscheidungsfindung im gesamten Unternehmen.

2. Datenmanagement und -integration

Stellen Sie sicher, dass Sie über eine robuste Dateninfrastruktur verfügen, die die Erfassung, Speicherung und Verarbeitung großer Datenmengen unterstützt. Integrieren Sie Daten aus verschiedenen internen und externen Quellen, um eine ganzheitliche Analyse zu ermöglichen.

- Entwickeln Sie Datenpipelines und Integrationsprozesse, um Daten aus unterschiedlichen Systemen und Quellen zu extrahieren, zu transformieren und zu laden (ETL).

- Sorgen Sie für Datenqualität und Datensicherheit, indem Sie bewährte Praktiken für die Datenbereinigung, -normalisierung und -sicherheit implementieren.

- Erwägen Sie die Nutzung von Cloud-basierten Datenplattformen oder Data Lakes, um Flexibilität, Skalierbarkeit und Zugänglichkeit der Daten zu verbessern.

3. Auswahl geeigneter Technologien und Werkzeuge

Wählen Sie die richtigen Technologien und Werkzeuge aus, die Ihren spezifischen Anforderungen an Advanced-Analytics entsprechen. Berücksichtigen Sie dabei Aspekte wie Funktionalität, Skalierbarkeit, Benutzerfreundlichkeit und Integrationsfähigkeit.

- Analysieren Sie verschiedene Advanced-Analytics Plattformen, Softwarelösungen und Tools basierend auf Ihren Bedürfnissen in den Bereichen Data Mining, maschinelles Lernen, Predictive Analytics und Visualisierung.

- Bewerten Sie die Kosten-Nutzen-Verhältnisse der Technologien und Werkzeuge und berücksichtigen Sie die langfristigen Auswirkungen auf Ihr Unternehmen.

- Bereiten Sie Ihr IT-Team und Ihre Datenanalyse-Spezialisten auf die Nutzung der ausgewählten Technologien vor und bieten Sie Schulungen und Unterstützung für eine effektive Implementierung.

4. Modellentwicklung und Implementierung

Entwickeln Sie Analysemodelle und Algorithmen, die auf den gesammelten Daten basieren, um spezifische Geschäftsprobleme zu lösen oder Chancen zu identifizieren. Implementieren Sie diese Modelle in produktive Systeme und überwachen Sie kontinuierlich deren Leistung und Genauigkeit.

- Arbeiten Sie eng mit Datenwissenschaftlern und Analysten zusammen, um prädiktive Modelle, Klassifizierungsverfahren, Clustering-Algorithmen und andere fortgeschrittene Analysetechniken zu entwickeln.

- Validieren und optimieren Sie die Modelle durch Testläufe und Evaluierung anhand historischer Daten, um deren Vorhersagegenauigkeit und Relevanz sicherzustellen.

- Implementieren Sie die entwickelten Modelle in Ihre bestehenden Geschäftsprozesse und Systeme, um datengesteuerte Entscheidungen in Echtzeit zu ermöglichen.

5. Überwachung, Evaluierung und Optimierung

Richten Sie ein Monitoring- und Evaluierungssystem ein, um die Leistung der implementierten Advanced-Analytics Lösungen kontinuierlich zu überwachen. Nutzen Sie die gewonnenen Erkenntnisse zur kontinuierlichen Verbesserung und Optimierung Ihrer Datenstrategie.

- Definieren Sie KPIs und Metriken zur Bewertung des Geschäftsnutzens und der ROI Ihrer Advanced-Analytics Initiativen.

- Führen Sie regelmäßige Audits und Reviews durch, um die Qualität der Daten, die Modellgenauigkeit und die Benutzerakzeptanz zu überprüfen.

- Iterieren Sie auf Basis der gesammelten Erkenntnisse und Feedbacks, um neue Geschäftsmöglichkeiten zu identifizieren und Herausforderungen proaktiv anzugehen.

Durch eine sorgfältige Planung, strategische Nutzung von Daten und die richtige Auswahl an Technologien können Unternehmen Advanced-Analytics erfolgreich implementieren und einen Wettbewerbsvorteil durch datengesteuerte Entscheidungen erzielen.

Trends im Bereich Advanced-Analytics

Die Entwicklung im Bereich Advanced-Analytics ist dynamisch und unterliegt ständigen Veränderungen durch technologische Fortschritte und sich wandelnde Geschäftsanforderungen. Hier sind einige der zukünftigen Trends, die im Bereich Advanced-Analytics zu erwarten sind:

1. Erweiterung der KI und maschinelles Lernen

Die Integration von künstlicher Intelligenz (KI) und maschinellem Lernen wird weiter zunehmen, um fortschrittliche Analysemodelle zu entwickeln, die komplexe Muster und Zusammenhänge in großen Datensätzen erkennen können.

- Fortgeschrittene Algorithmen für Deep Learning und neuronale Netzwerke werden weiterentwickelt, um präzisere Vorhersagen und Entscheidungen zu ermöglichen.

- Automatisierte Modellierung und Optimierung von Machine-Learning-Modellen werden zunehmend implementiert, um den Entwicklungsprozess zu beschleunigen und die Genauigkeit zu verbessern.

- Einsatz von Natural Language Processing (NLP) und Computer Vision für die Verarbeitung unstrukturierter Daten wie Texte, Bilder und Videos wird erweitert, um neue Einsichten zu gewinnen.

2. Echtzeit-Analyse und Streaming-Datenverarbeitung

Die Nachfrage nach Echtzeit-Analyse und Streaming-Datenverarbeitung wird weiter steigen, um sofortige Einblicke in sich schnell ändernde Datenströme zu erhalten und darauf basierende Entscheidungen zu treffen.

- Verbesserungen in der Skalierbarkeit und Leistung von Streaming Analytics Plattformen wie Apache Kafka und Spark Streaming werden dazu beitragen, große Datenmengen in Echtzeit zu verarbeiten.

- Integration von IoT-Daten (Internet der Dinge) für die Analyse von Sensordaten in Echtzeit zur Überwachung von Geräten, Anlagen und Umgebungen.

- Erweiterung der Anwendungen für Edge Analytics, um Daten direkt an der Quelle zu verarbeiten und latenzempfindliche Anwendungen zu unterstützen.

3. Erweiterte Datenvisualisierung und interaktive Dashboards

Datenvisualisierungstechniken werden weiterentwickelt, um komplexe Datenmuster intuitiv darzustellen und Nutzern die Exploration und Analyse großer Datensätze zu erleichtern.

- Integration von Augmented Reality (AR) und Virtual Reality (VR) für immersive Datenvisualisierungserfahrungen und 3D-Datenanalysen.

- Entwicklung von interaktiven Dashboards und Self-Service-Analysetools, die es Benutzern ermöglichen, Daten eigenständig zu untersuchen und personalisierte Berichte zu erstellen.

- Verwendung von fortgeschrittenen Diagrammtypen, Heatmaps, und geografischen Visualisierungen zur Darstellung komplexer Zusammenhänge und Trends.

4. Datenschutz und ethische Herausforderungen

Mit der zunehmenden Nutzung von Daten und Analysetechnologien werden auch Datenschutzfragen und ethische Bedenken verstärkt diskutiert und adressiert werden müssen.

- Entwicklung und Implementierung von robusten Datenschutzrichtlinien und Sicherheitsmaßnahmen, um die Vertraulichkeit und Integrität der Daten zu gewährleisten.

- Berücksichtigung ethischer Grundsätze bei der Datenerfassung, -verarbeitung und -nutzung, um sicherzustellen, dass die Analyse verantwortungsbewusst und transparent durchgeführt wird.

- Einhaltung gesetzlicher Vorschriften und Richtlinien wie der DSGVO (Datenschutz-Grundverordnung) und anderen datenschutzrechtlichen Bestimmungen.

Die Zukunft von Advanced-Analytics wird durch Innovationen in der Datenverarbeitung, fortgeschrittenen Analysemethoden und einem zunehmenden Fokus auf datengesteuerte Entscheidungen geprägt sein. Unternehmen sollten diese Trends im Auge behalten und ihre Strategien entsprechend anpassen, um wettbewerbsfähig zu bleiben und Geschäftschancen zu nutzen.

Fazit

Advanced-Analytics geht über klassisches Reporting hinaus: Statt nur zu erklären, was passiert ist, helfen statistische Modelle und Machine Learning dabei, zukünftige Entwicklungen zu antizipieren und Entscheidungen besser vorzubereiten.

Der größte Nutzen entsteht, wenn die Modelle nicht „im Lab“ bleiben, sondern in Prozesse integriert werden – zum Beispiel in Kampagnensteuerung, CRM, Pricing oder Bestandsplanung. Erst dann werden Insights zu messbarem Business-Impact.

Wichtig ist dabei weniger der „perfekte Algorithmus“ als saubere Daten, sinnvolle Features und eine klare Fragestellung. Transparenz (Erklärbarkeit), Monitoring und regelmäßiges Retraining entscheiden über langfristige Qualität.

Wer Advanced-Analytics pragmatisch einführt, baut Schritt für Schritt einen Kreislauf aus Lernen, Vorhersagen und Optimierung – und schafft so einen nachhaltigen Wettbewerbsvorteil.

- Start klein: 1–2 Use Cases mit klaren KPIs (z. B. Churn, Lead-Scoring, Forecast).

- Datenfundament sichern: Tracking, Datenqualität, Governance und eine stabile Pipeline.

- In Entscheidungen einbetten: Scores/Empfehlungen in Tools und Workflows nutzbar machen.

- Kontinuierlich verbessern: Monitoring, A/B-Tests, Feedback-Loops und Retraining.

Quellen und empfohlene Ressourcen

Die folgenden Quellen helfen dir dabei, Advanced Analytics (Predictive & Prescriptive Analytics, Modellierung, Simulation, Clustering und Recommender-Systeme) fundiert zu vertiefen.

- Advanced Analytics – European Banking Authority (EBA): “Final Report on Big Data and Advanced Analytics” (PDF)

- Advanced Analytics – European Central Bank (ECB): “Advanced analytics: new methods and applications for macroeconomic policy” (Call for papers)

- Advanced Analytics – Bank of England: “Advanced analytics: new methods and applications for macroeconomic policy” (Call for papers, PDF)

- Advanced Analytics – Reuters (Risk & Compliance): “As compliance demands more technology, here’s one approach to reporting”

- Advanced Analytics – SpringerOpen: “Organizational implications of advanced analytics” (Open Access)

- Advanced Analytics – Springer: “An introduction to data mining and other techniques for advanced analytics”

- Advanced Analytics – Springer: “Adding value to business applications with embedded advanced analytics”

- Advanced Analytics – Paper (PDF): “Model Selection Management Systems: The Next Frontier of Advanced Analytics”

- Advanced Analytics – Paper (PDF): “In-RDBMS Hardware Acceleration of Advanced Analytics”

- Advanced Analytics – arXiv: “Scaling-Up Reasoning and Advanced Analytics on BigData”

- Advanced Analytics – arXiv: “Towards a Taxonomy for the Use of Synthetic Data in Advanced Analytics”

- Advanced Analytics – Springer Book: “Advanced Analytics and Learning on Temporal Data”

- Advanced Analytics – MIT CTL: “Increasing Resilience Through Advanced Analytics in a Pharmaceutical Company”

- Advanced Analytics – ScienceDirect: “Big Data and Advanced Analytics in Industry 4.0: a comparative analysis across the European Union”

- Advanced Analytics – PubMed: “Improving Health Care with Advanced Analytics: Practical Considerations”

FAQs zu Advanced-Analytics

Was ist Advanced-Analytics?

Advanced-Analytics beschreibt fortgeschrittene Datenanalysen, die über Reporting und Dashboards hinausgehen. Ziel ist es, mit statistischen Modellen, Data Mining und Machine Learning Muster zu erkennen, zukünftiges Verhalten vorherzusagen und Entscheidungen zu unterstützen.

Was ist der Unterschied zwischen Advanced-Analytics und klassischer Analytics?

Klassische Analytics beantwortet vor allem „Was ist passiert?“ (deskriptiv) und „Warum?“ (diagnostisch). Advanced-Analytics ergänzt „Was wird passieren?“ (prädiktiv) und „Was sollten wir tun?“ (präskriptiv) – z. B. mit Forecasts und Optimierung.

Advanced-Analytics vs. Business Intelligence (BI): Wo liegt der Unterschied?

Business Intelligence fokussiert sich meist auf Datenintegration, Reporting und historische Auswertungen. Advanced-Analytics baut darauf auf und nutzt Modelle (z. B. Machine Learning), um Vorhersagen zu treffen, Szenarien zu simulieren und Entscheidungen zu optimieren.

Advanced-Analytics vs. Data Science: Ist das dasselbe?

Data Science ist der übergeordnete Bereich rund um Daten, Modelle, Engineering und Experimente. Advanced-Analytics ist typischerweise der anwendungsnahe Teil davon: konkrete Modelle und Analysen, die direkt in Prozesse, Produkte oder Entscheidungen übersetzt werden.

Was ist Predictive-Analytics in Advanced-Analytics?

Predictive-Analytics schätzt die Wahrscheinlichkeit zukünftiger Ereignisse auf Basis historischer Daten. Beispiele sind Churn-Prognosen, Lead-Scoring oder Nachfrage-Forecasts, um Prioritäten, Budgets und Maßnahmen datenbasiert zu steuern.

Welche Advanced-Analytics-Methoden sind am wichtigsten?

Zu den häufigsten Advanced-Analytics-Methoden zählen Regression & Klassifikation, Entscheidungsbäume/Boosting, Clustering (Unsupervised Learning), Kohortenanalyse, Anomalieerkennung sowie Recommender-Systeme. Welche Methode passt, hängt von Datenlage, Ziel und Umsetzbarkeit ab.

Was ist Clustering in Advanced-Analytics?

Clustering gruppiert Nutzer, Kunden oder Produkte nach Ähnlichkeit – ohne vorgegebene Labels. Typische Anwendungen sind Kundensegmente für Targeting/Personalisierung, Produktgruppen für Navigation sowie die Erkennung von Ausreißern (Anomalien).

Wie funktionieren Empfehlungsalgorithmen in Advanced-Analytics?

Recommender-Systeme erzeugen personalisierte Vorschläge wie „Next Best Product“ oder „Next Best Content“. Häufig werden regelbasierte Logiken, Collaborative Filtering und content-basierte Modelle kombiniert – oft ergänzt um Predictive Scores (z. B. Kaufwahrscheinlichkeit).

Welche Advanced-Analytics-Beispiele gibt es im Marketing?

Gängige Advanced-Analytics-Beispiele im Marketing sind Churn Prediction, Customer Lifetime Value (CLV) Prognosen, Uplift-Modelle, Segmentierung per Clustering und Next-Best-Action für CRM-Kampagnen. Ziel ist, Budgets und Personalisierung messbar zu verbessern.

Wie implementiert man Advanced-Analytics im Unternehmen erfolgreich?

Starte mit 1–2 Use Cases mit klaren KPIs, baue eine robuste Datenpipeline auf und integriere Ergebnisse in Workflows (z. B. CRM, Kampagnensteuerung). Wichtig sind Monitoring, regelmäßiges Retraining und eine Feedback-Schleife, damit Modelle langfristig verlässlich bleiben.